Dans ce guide, vous verrez :

- Ce qu’est un serveur MCP et ce que cette technologie apporte.

- Comment sélectionner les meilleurs serveurs MCP du marché.

- Une liste des 10 meilleurs serveurs MCP pour prendre en charge vos agents et flux de travail d’IA.

Plongeons dans l’aventure !

Qu’est-ce qu’un serveur MCP ?

MCP, abréviation de “Model Context Protocol“, est un protocole open-source qui normalise la communication entre les LLM et les outils/services externes. En d’autres termes, il s’agit d’un langage universel que les agents d’intelligence artificielle peuvent utiliser pour interagir en toute sécurité avec n’importe quel outil dont ils ont besoin pour accomplir une tâche.

Un serveur MCP met en œuvre le protocole MCP, exposant un ensemble d’outils qu’un agent d’intelligence artificielle peut découvrir et utiliser. Cela est possible grâce aux technologies SSE et Streamable HTTP sur lesquelles repose le protocole.

Il convient de noter que le MCP n’est qu’un des nombreux protocoles d’IA disponibles.

Les principaux avantages offerts par l’intégration des serveurs MCP dans vos flux de travail en matière d’IA sont les suivants :

- Normalisation: Ils offrent à une application d’IA un moyen cohérent d’interagir avec des outils tiers. Il n’est donc pas nécessaire d’écrire un code d’intégration personnalisé pour l’API, l’authentification et le format de données propres à chaque outil.

- Possibilité de découverte: Les agents peuvent interroger un serveur MCP pour savoir quels sont les outils disponibles et comment les utiliser. Cela permet une exécution dynamique et autonome des tâches, ce qui est au cœur de tout agent d’intelligence artificielle.

- Flexibilité: Grâce aux serveurs MCP, les agents d’intelligence artificielle ne communiquent qu’avec le serveur, et non directement avec les outils finaux. Cela vous permet de contrôler les outils auxquels l’IA peut accéder.

Comment sélectionner les meilleurs serveurs MCP

Le référentiel Awesome MCP Servers répertorie des centaines de serveurs MCP utiles. Avec un tel choix de serveurs, sélectionner le meilleur pour vos besoins nécessite des critères d’évaluation clairs.

En particulier, les facteurs clés à garder à l’esprit lors de la sélection des meilleurs serveurs MCP sont les suivants :

- Cas d’utilisation typiques: Le serveur est-il basé sur des services qui vous intéressent ou que vous utilisez déjà ? Fournit-il des outils qui vous permettent d’accomplir vos tâches les plus courantes et les plus fastidieuses ? La valeur d’un serveur MCP se mesure à sa capacité à automatiser des flux de travail spécifiques.

- Outils clés: La liste des outils les plus pertinents exposés par le serveur MCP.

- Confiance et popularité de la communauté: Les étoiles GitHub sont un indicateur fort de l’adoption et de la confiance de la communauté. De plus, un nombre d’étoiles plus élevé tend à correspondre à un serveur plus stable et mieux documenté. D’autres facteurs à prendre en compte sont le nombre de contributeurs, les contributions récentes et les forks.

- Licence: Les serveurs MCP sont généralement des logiciels libres. Outre la licence du serveur, vous devez également examiner les licences de tout logiciel tiers dont le MCP dépend. Si vous utilisez déjà ces outils et qu’ils sont couverts par vos licences existantes, vous pouvez les utiliser. Dans le cas contraire, vous devrez évaluer leurs conditions de licence et éventuellement leur allouer un budget.

- Langage de programmation: Le langage de programmation utilisé pour développer le serveur MCP. Cela influence vos exigences, votre installation et vos éventuelles contributions au code source.

Les 10 meilleurs serveurs MCP

Cette section présente une liste des meilleurs serveurs MCP, sélectionnés et classés selon les critères décrits précédemment.

1. Données lumineuses

Le serveur MCP de Bright Data offre les capacités de collecte de données essentielles à toute application d’intelligence artificielle. Chaque système d’intelligence artificielle ayant besoin d’accéder à des données de haute qualité, ce serveur MCP est conçu pour prendre en charge pratiquement tous les cas d’utilisation.

Plus précisément, il dote les agents d’intelligence artificielle et les flux de travail d’outils puissants permettant de récupérer des données web en temps réel. Ces outils permettent à l’IA d’ancrer ses réponses et d’interagir avec précision avec les pages web pendant l’exécution des tâches.

La grande majorité des projets axés sur l’IA nécessitent des données fraîches et actualisées pour rester compétitifs et efficaces. C’est pourquoi le serveur Bright Data MCP s’impose comme une solution de premier plan.

Découvrez comment l’intégrer en suivant la documentation officielle.

Cas d’utilisation typiques:

- Recherche d’informations en temps réel: Vous pouvez demander des informations actualisées. Par exemple : “Quels sont les cinq sujets d’actualité les plus populaires sur The Guardian en ce moment ? “Quels sont les 5 sujets d’actualité les plus en vogue sur The Guardian en ce moment ?”. L’IA utilisera l’outil

search_engineavec une requête telle que"top stories The Guardian"pour obtenir les titres actuels. - Scraping et extraction de données sur le web: Le serveur est conçu pour les tâches de scraping. Il s’intègre au Web Unlocker de Bright Data pour accéder au contenu de n’importe quelle page web en contournant toutes les mesures anti-bots. Cela signifie que vous pouvez créer un agent qui effectue des tâches d’extraction de données sur le web sans craindre d’être bloqué.

- Contourner les restrictions géographiques: De nombreux sites Web affichent un contenu différent en fonction de votre situation géographique ou ne sont accessibles qu’à partir de régions spécifiques. Pour y remédier, le serveur MCP de Bright Data peut acheminer ses requêtes via un vaste réseau de proxy comptant plus de 150 millions d’adresses IP réparties dans le monde entier.

- Automatisation interactive du navigateur: Le serveur fournit des outils pour le “contrôle du navigateur”, ce qui signifie qu’un agent d’intelligence artificielle peut faire plus que simplement télécharger le code HTML brut d’une page. Il peut interagir avec un site web de manière dynamique.

- Extraction de données structurées: Le serveur excelle dans l’extraction de données structurées en JSON à partir des principales plateformes grâce aux API Web Scraper. Celles-ci permettent d’extraire en temps réel des données structurées d’Instagram, de LinkedIn, d’Amazon et de nombreux autres sites par le biais du web scraping. Par exemple, vous pouvez demander à un agent de récupérer les détails d’un produit à partir d’une URL d’Amazon. L’agent utilisera alors un outil pour récupérer ces données.

Outils clés:

search_engine: Récupère les résultats de recherche de Google, Bing ou Yandex. Retourne les résultats des SERP en markdown.scrape_as_markdown: Scrape une seule URL de page web avec des options avancées pour l’extraction de contenu et renvoie les résultats en Markdown. Cet outil peut débloquer n’importe quelle page web, même si elle utilise la détection des robots ou des CAPTCHA.scrape_as_html: Scrape une seule URL de page web avec des options avancées pour l’extraction de contenu et renvoie les résultats en HTML. Cet outil peut débloquer n’importe quelle page web, même si elle utilise la détection des robots ou des CAPTCHA.session_stats: informe l’utilisateur sur l’utilisation de l’outil au cours de cette sessionweb_data_amazon_product: Lit rapidement les données structurées des produits Amazon.web_data_amazon_product_reviews: Permet de lire rapidement les données structurées des évaluations de produits Amazon.web_data_linkedin_person_profile: Lit rapidement les données structurées du profil des personnes sur LinkedIn.web_data_linkedin_company_profile: Lit rapidement les données structurées du profil d’entreprise LinkedIn.web_data_zoominfo_company_profile: Lit rapidement les données structurées du profil d’entreprise ZoomInfo.web_data_instagram_profiles: Lit rapidement les données structurées des profils Instagram.web_data_instagram_posts: Lit rapidement les données structurées des posts Instagram.web_data_instagram_reels: Lit rapidement les données structurées des bobines Instagram.web_data_instagram_comments: Lit rapidement les données structurées des commentaires Instagram.web_data_facebook_posts: Lit rapidement les données structurées des messages Facebook.web_data_facebook_marketplace_listings: Permet de lire rapidement les données structurées relatives aux inscriptions sur les places de marché Facebook.web_data_facebook_company_reviews: Permet de lire rapidement les données structurées relatives aux évaluations d’entreprises sur Facebook.web_data_x_posts: Lit rapidement les données structurées des messages X. Nécessite une URL X post valide.web_data_zillow_properties_listing: Permet de lire rapidement les données structurées des annonces immobilières de Zillow.web_data_booking_hotel_listings: Permet de lire rapidement les données structurées relatives aux réservations d’hôtels.web_data_youtube_videos: Lit rapidement les données structurées des vidéos YouTube.scraping_browser_navigate: Navigue une session de navigateur de scraping vers une nouvelle URL.scraping_browser_go_back: Retourne à la page précédente.scraping_browser_go_forward: Passe à la page suivante.scraping_browser_click: Clics sur un élément.scraping_browser_links: Récupère tous les liens de la page actuelle, le texte et les sélecteurs.scraping_browser_type: Tape du texte dans un élément.scraping_browser_wait_for: Attend qu’un élément soit visible sur la pagescraping_browser_screenshot: Effectue une capture d’écran de la page en coursscraping_browser_get_html: Obtient le contenu HTML de la page en cours.scraping_browser_get_text: Obtient le contenu textuel de la page actuelleweb_data_amazon_product_search: Lit rapidement les données structurées de recherche de produits Amazon.web_data_walmart_product: Lit rapidement les données structurées des produits Walmart.web_data_walmart_seller: Lit rapidement les données structurées des vendeurs Walmart.web_data_ebay_product: Lit rapidement les données structurées des produits eBay.web_data_homedepot_products: Lit rapidement les données structurées des produits homedepot.web_data_zara_products: Permet de lire rapidement les données structurées relatives aux produits Zara.web_data_etsy_products: Lit rapidement les données structurées des produits Etsy.web_data_bestbuy_products: Lit rapidement les données structurées sur les produits Best Buy.web_data_linkedin_job_listings: Lit rapidement les données structurées des offres d’emploi de LinkedIn.web_data_linkedin_posts: Lit rapidement les données structurées des posts LinkedIn.web_data_linkedin_people_search: Lit rapidement les données structurées de recherche de personnes sur LinkedIn.web_data_crunchbase_company: Lit rapidement les données structurées de l’entreprise Crunchbase.web_data_facebook_events: Lit rapidement les données structurées des événements Facebook.web_data_tiktok_profiles: Lit rapidement les données structurées des profils TikTok.web_data_tiktok_posts: Lit rapidement les données structurées des messages TikTok.web_data_tiktok_shop: Lit rapidement les données structurées des boutiques TikTok.web_data_tiktok_comments: Lit rapidement les données structurées des commentaires TikTok.web_data_google_maps_reviews: Permet de lire rapidement les données structurées relatives aux avis sur Google Maps.web_data_google_shopping: Lit rapidement les données structurées de Google Shopping.web_data_google_play_store: Lit rapidement les données structurées du Google Play Store.web_data_apple_app_store: Lit rapidement les données structurées de l’Apple App Store.web_data_reuter_news: Lit rapidement les données structurées de Reuters sur les actualités.web_data_github_repository_file: Lit rapidement les données structurées du dépôt GitHub.web_data_yahoo_finance_business: Lit rapidement les données structurées de Yahoo Finance sur les entreprises.web_data_youtube_profiles: Lit rapidement les données structurées des profils YouTube.web_data_youtube_comments: Lit rapidement les données structurées des commentaires YouTube.web_data_reddit_posts: Lit rapidement les données structurées des posts Reddit.

Pour découvrir tous les outils, consultez le dépôt officiel du serveur MCP de Bright Data.

Confiance et popularité de la communauté: Le dépôt a plus de 700 étoiles. Il est bien documenté et largement adopté, comme le démontrent les plus de 100 forks.

Sites web compatibles : LinkedIn, sites immobiliers, Facebook, Reddit, YouTube, et bien d’autres encore.

Intégrations populaires : N8N, Claude, Cursor, Perplexity, OpenAI, VS Code, Windsurf, et plus encore.

Licence: Le serveur MCP est un logiciel libre (licence MIT). Sous le capot, il s’appuie sur les produits de Bright Data, qui sont fournis avec une version d’essai gratuite.

Langage de programmation: Node.js.

2. GitHub

Le serveur GitHub MCP est un outil indispensable pour toute équipe impliquée dans le développement de logiciels. Il aide les agents d’intelligence artificielle à devenir des participants actifs dans le cycle de vie du développement. Cela signifie qu’ils sont capables de gérer les référentiels, de suivre les problèmes et même d’interagir avec le code.

Cas d’utilisation typiques:

- Automatisation des flux de travail GitHub: Au lieu de cliquer manuellement sur l’interface de GitHub, vous pouvez automatiser des actions. Par exemple, vous pourriez demander : “Quel est le statut de mon dernier PR ?” et le robot pourrait utiliser les outils

list_pull_requestsetget_pull_request_statuspour trouver et rapporter la réponse. - Extraction et analyse de données à partir de dépôts GitHub: Il s’agit d’utiliser le serveur pour extraire des informations de GitHub à des fins d’analyse ou de reporting. Par exemple, vous pouvez créer un tableau de bord qui répertorie toutes les demandes d’extraction en cours et leur état actuel.

Outils clés:

get_issue: Permet d’obtenir le contenu d’une question dans un référentiel.create_issue: Crée une nouvelle question dans un dépôt GitHub.add_issue_comment: Ajoute un commentaire à une question.list_issues: Liste et filtre les problèmes du référentiel.update_issue: Met à jour un problème existant dans un dépôt GitHub.get_pull_request: Permet d’obtenir les détails d’une demande d’extraction spécifique.list_pull_requests: Liste et filtre les demandes d’extraction du référentiel.merge_pull_request: Fusionne une pull request.get_pull_request_diff: Obtient le différentiel d’une demande d’extraction.create_pull_request: Crée une nouvelle demande d’extraction.update_pull_request: Met à jour une demande d’extraction existante dans un dépôt GitHub.delete_file: Supprime un fichier d’un dépôt GitHub.list_branches: Liste les branches d’un dépôt GitHub.push_files: Pousse plusieurs fichiers en une seule livraison.search_repositories: Recherche les dépôts GitHub.create_repository: Crée un nouveau dépôt GitHub.fork_repository: Met en place un référentiel.create_branch: Crée une nouvelle branche.run_workflow: Déclenche un flux de travail via l’événement workflow_dispatch.get_workflow_run: Permet d’obtenir les détails d’un flux de travail spécifique.get_workflow_run_logs: Télécharge les journaux de l’exécution d’un flux de travail.rerun_workflow_run: Permet de réexécuter un flux de travail complet.rerun_failed_jobs: Ne réexécute que les travaux qui ont échoué dans le cadre d’un flux de travail.cancel_workflow_run: Annule un flux de travail en cours.

Découvrez tous les outils disponibles dans le dépôt officiel de GitHub.

Confiance et popularité de la communauté: Le dépôt a plus de 16,4k étoiles et est clairement documenté. Le nombre élevé de PR (45+), de contributeurs (60+) et de forks (1.2k+) en fait un dépôt largement adopté et maintenu.

Licence: Ce serveur MCP est open source (licence MIT). Il nécessite un compte GitHub, qui propose des niveaux gratuits et payants.

Langage de programmation: Go.

3. Supabase

Supabase est une plateforme populaire de backend-as-a-service open-source. Son serveur MCP donne aux agents d’intelligence artificielle un accès programmatique complet à la base de données, à l’authentification et au stockage de votre projet. Cela ouvre la voie à une gestion du backend en langage naturel.

Cas d’utilisation typiques:

- Gestion de base de données et interrogation: Vous pouvez interagir avec votre base de données Postgres sans écrire vous-même du code SQL. Par exemple, vous pouvez demander : “Combien d’utilisateurs se sont inscrits la semaine dernière ?”. L’agent utiliserait l’outil

execute_sql`pour exécuter les requêtes nécessaires. - Administration des projets et des comptes: Le serveur fournit des outils pour gérer vos projets Supabase et vos paramètres d’organisation. Par exemple, vous pouvez avoir un agent qui crée un nouveau projet, met en pause un projet inactif, ou obtient une liste de tous vos projets.

- Débogage et surveillance: En cas de problème, vous pouvez utiliser l’agent comme première ligne de défense. Par exemple, vous pouvez demander : “Montrez-moi les journaux de l’API de la dernière heure pour voir s’il y a des erreurs”. Pour répondre à cette demande, l’agent utilise l’outil

get_logs.

Outils clés:

search_docs: Recherche dans la documentation de Supabase des informations à jour.list_tables: dresse la liste de toutes les tables des schémas spécifiés.list_migrations: Liste toutes les migrations dans la base de données.apply_migration: Applique une migration SQL à la base de données.execute_sql: Exécute le langage SQL brut dans la base de données.get_project_url: Obtient l’URL de l’API pour un projet.get_anon_key: Permet d’obtenir la clé API anonyme d’un projet.generate_typescript_types: Génère des types TypeScript basés sur le schéma de la base de données.list_storage_buckets: Liste tous les entrepôts de stockage d’un projet Supabase.get_storage_config: Permet d’obtenir la configuration du stockage pour un projet Supabase.update_storage_config: Met à jour la configuration de stockage d’un projet Supabase (nécessite un abonnement payant).

La liste complète des outils disponibles se trouve dans la section dédiée du référentiel.

Confiance et popularité de la communauté: Le dépôt a plus de 1,7k étoiles. Il est bien documenté et largement adopté (150+ forks).

Licence: Open-source (Apache 2.0). Notez que Supabase propose à la fois des plans gratuits et des plans payants.

Langage de programmation: Node.js.

4. Dramaturge

Le serveur Playwright MCP permet aux LLM d’interagir avec les pages Web en tirant parti de l’API d’automatisation du navigateur Playwright. En coulisses, il s’appuie sur des instantanés d’accessibilité. Cela permet de s’affranchir des captures d’écran et des modèles d’IA dotés de capacités visuelles.

En savoir plus sur ce que Playwright a à offrir.

Cas d’utilisation typiques:

- Interaction de type humain: Votre agent d’intelligence artificielle aura la possibilité d’interagir avec les pages web, par exemple en cliquant, en naviguant, en prenant des captures d’écran, etc. Cela signifie que vous pouvez créer des agents d’IA avancés qui effectuent des tâches réelles sur des sites web à l’aide d’une simple invite (par exemple, de manière similaire à ce que vous pouvez réaliser avec Browser-Use).

- Génération de tests automatisés: Pour ce faire, vous devez décrire un parcours utilisateur complet. L’IA peut utiliser ses outils de contrôle du navigateur pour effectuer les étapes et utiliser l’outil

browser_generate_playwright_testpour produire un script de test Playwright.

Outils clés:

browser_snapshot: Capture un instantané de l’accessibilité de la page en cours.browser_click: Effectue un clic sur une page web.browser_drag: Effectue un glisser-déposer entre deux éléments.browser_hover: Le navigateur survole l’élément sur la page.browser_type: Saisir du texte dans un élément modifiable.browser_select_option: Sélectionne une option dans une liste déroulante.browser_wait_for: Attend que le texte apparaisse ou disparaisse, ou qu’un certain temps s’écoule.browser_navigate: Navigue vers une URL.browser_pdf_save: Enregistre la page au format PDF.browser_tab_list: Liste les onglets du navigateur.browser_tab_new: ouvre un nouvel onglet.browser_tab_select: Sélectionne un onglet par index.browser_tab_close: Ferme un onglet.browser_generate_playwright_test: Génère un test Playwright pour le scénario donné.browser_screen_move_mouse: Déplace la souris à une position donnée.browser_screen_click: Cliquez sur le bouton gauche de la souris.browser_screen_drag: Fait glisser le bouton gauche de la souris.browser_screen_type: Types de texte.browser_press_key: Appuie sur une touche du clavier.

La section “Outils” du référentiel Playwright les décrit tous.

Confiance et popularité de la communauté: Les 13,1k+ étoiles GitHub démontrent que ce dépôt est largement reconnu et adopté. Il a également plusieurs contributeurs et forks (900+), ainsi qu’une bonne documentation.

Licence: Open-source (Apache 2.0).

Langage de programmation: Node.js.

5. Notion

Le serveur MCP de Notion transforme Notion en une base de connaissances dynamique que les agents d’intelligence artificielle peuvent lire et sur laquelle ils peuvent écrire. Cela donne à votre IA le pouvoir d’automatisation nécessaire pour gérer des tâches telles que la documentation, la gestion de projet et la création de contenu.

Cas d’utilisation typiques:

- Gestion automatisée des tâches: Vous pouvez gérer vos plans de projet en utilisant le langage naturel. L’IA créera une nouvelle entrée dans votre base de données avec les propriétés que vous avez demandées.

- Création de nouvelles bases de données Notion: L’agent IA peut créer de nouvelles bases de données de notions. Vous pouvez utiliser une invite du type : “Créez une nouvelle base de données pour suivre mes demandes d’emploi : “Créez une nouvelle base de données pour suivre mes demandes d’emploi. Elle doit comporter des colonnes pour le nom de l’entreprise, le poste et un lien vers la description du poste”.

- Recherche de connaissances: Vous pouvez trouver des solutions à des problèmes techniques en demandant à l’agent de rechercher dans toute la documentation.

Outils clés:

Recherche: Trouvez tout ce qui se trouve dans votre espace de travail Notion, dans les applications connectées ou sur le Web en posant des questions en langage clair.Recherche par titre: Outil de recherche de secours lorsque l’abonnement AI n’est pas disponible. Effectue une recherche par mot-clé sur les titres des pages uniquement.Vue: Permet d’examiner une page, une base de données, un fichier ou un utilisateur de votre espace de travail Notion pour voir ce qu’il contient.Obtenir les commentaires: Liste tous les commentaires sur une page ou un bloc spécifique, y compris les discussions en filigrane.Obtenir unutilisateur : permet d’obtenir des informations détaillées sur un utilisateur spécifique en fonction de son numéro d’identification ou de sa référence.Créer des pages: Crée de nouvelles pages dans votre espace de travail avec le contenu de votre choix. Précisez l’endroit où vous souhaitez que cette page soit ajoutée, sinon elle sera une page privée par défaut.Créer un commentaire: Ajoute un commentaire à une page ou à un bloc.Mettre à jour la page: Modifie les pages existantes en changeant leur titre, leur contenu ou d’autres propriétés.

La documentation sur les outils du serveur Notion MCP décrit quand utiliser chaque outil et fournit des invites utiles pour vous permettre de démarrer immédiatement.

La confiance et la popularité de la communauté: Il a plus de 2,3k étoiles et une bonne documentation. Il a également un bon nombre de contributions récentes, ce qui fait qu’il est bien entretenu et adopté.

Licence : Open-source (licence MIT). Notion lui-même fournit un large éventail de fonctionnalités avec le plan gratuit, mais certaines sont fournies pour les utilisateurs payants.

Langage de programmation: Node.js.

6. Atlassian

Le serveur MCP d’Atlassian est spécifiquement créé pour automatiser les flux de travail qui impliquent Confluence, Jira, Jira Cloud et les déploiements de serveurs/centres de données à l’aide de LLM. Ces solutions sont largement utilisées pour la documentation, le suivi des problèmes et la collaboration en équipe. Ainsi, leur intégration avec l’IA permet à des agents intelligents de gérer les tickets, de mettre à jour la documentation, et plus encore.

Cas d’utilisation typiques:

- Automatisation intelligente de Jira: En sollicitant correctement le LLM, vous pouvez automatiser les flux de travail Jira pour la recherche et la récupération d’informations, ainsi que pour la création et la gestion de problèmes.

- Gestion de la documentation de Confluence: Vous pouvez transformer Confluence en une base de connaissances dynamique avec laquelle vous pouvez discuter. Vous pouvez créer et gérer la documentation directement à partir de votre chat. Vous pouvez également demander à l’agent de rechercher et de résumer la documentation pour vous.

Outils clés:

jira_search: Effectue des recherches dans les dossiers Jira.jira_create_issue: Crée une nouvelle question Jira.jira_update_issue: Met à jour une question Jira existante.confluence_search: Recherche dans le contenu de Confluence.confluence_get_page: Obtient le contenu d’une page spécifique.confluence_create_page: Crée une nouvelle page.confluence_update_page: Met à jour une page existante.

Lisez tous les outils disponibles dans la section Atlassian MCP server repository.

La confiance et la popularité de la communauté: Il a plus de 2,1k étoiles et une bonne documentation. Il a également beaucoup de contributeurs (50+) et de forks (360+), ce qui fait qu’il est bien entretenu et adopté.

Licence: Open-source (licence MIT). Notez que Jira et Atlassian proposent des offres gratuites et payantes.

Langage de programmation: Python, mais distribué uniquement via Docker.

7. Séréna

Serena MCP server est une boîte à outils d’agent de codage qui fonctionne directement sur votre base de code. Il fournit tous les outils typiques des capacités d’un IDE. En particulier, il :

- Utilise les LSP(Language Server Protocols) pour analyser et comprendre le code de manière sémantique.

- Peut lire et écrire du code, mais aussi exécuter des commandes shell.

- A une compréhension persistante d’une base de code spécifique, étant donné qu’elle comporte un système d’intégration et de mémoire.

Cas d’utilisation typiques:

- Codage alimenté par LLM: Serena est conçu pour toute tâche de codage. Il peut lire, écrire et exécuter du code. Il peut également lire les journaux et la sortie du terminal. Il prend en charge directement et indirectement des langages de programmation tels que Python, JavaScript, Go, etc.

Outils clés:

activate_project: Active un projet par son nom.create_text_file: Crée/écrit un fichier dans le répertoire du projet.delete_lines: Supprime une série de lignes dans un fichier.delete_memory: Supprime une mémoire de la mémoire spécifique au projet de Serena.execute_shell_command: Exécute une commande shell.find_symbol: Effectue une recherche globale (ou locale) des symboles contenant un nom/une sous-chaîne donné(e) (éventuellement filtré(e) par type).get_active_project: Obtient le nom du projet actuellement actif (le cas échéant) et répertorie les projets existants.get_current_config: Imprime la configuration actuelle de l’agent, y compris les modes actifs, les outils et le contexte.get_symbols_overview: Permet d’obtenir une vue d’ensemble des symboles de premier niveau définis dans un fichier ou un répertoire donné.instructions_initiales: Obtient les instructions initiales pour le projet en cours.insert_after_symbol: Insère le contenu après la fin de la définition d’un symbole donné.insert_at_line: Insère le contenu d’un fichier à une ligne donnée.list_dir: dresse la liste des fichiers et des répertoires du répertoire donné (éventuellement avec récursivité).list_memories: Liste les mémoires dans la mémoire spécifique au projet de Serena.prepare_for_new_conversation: Fournit des instructions pour la préparation d’une nouvelle conversation.read_file: Lit un fichier dans le répertoire du projet.read_memory: Lit la mémoire portant le nom donné dans la mémoire spécifique au projet de Serena.replace_lines: Remplace une série de lignes d’un fichier par un nouveau contenu.search_for_pattern: Effectue une recherche d’un modèle dans le projet.summarize_changes: Fournit des instructions pour résumer les modifications apportées à la base de code.

Découvrez la liste complète des outils dans le référentiel de Serena.

Confiance et popularité de la communauté: Serena a 2,9k+ étoiles et une très large documentation.

Licence: Open-source (licence MIT).

Langage de programmation: Python.

8. Système de fichiers

Le référentiel du serveur MCP pour le système de fichiers est conçu pour créer des agents IA qui gèrent les opérations de votre système de fichiers.

Outils clés:

read_file: Lit le contenu complet d’un fichier.write_file: Crée un nouveau fichier ou écrase un fichier existant.create_directory: Crée un nouveau répertoire ou s’assure qu’il existe.move_file: Déplace ou renomme des fichiers et des répertoires.

Accédez à la liste complète des outils disponibles dans le référentiel.

Confiance et popularité de la communauté: Ce dépôt a 56k+ étoiles, une large documentation, et un grand nombre de contributeurs (580+). Notez que ces mesures sont liées au dépôt de l’ensemble du projet, qui répertorie plusieurs serveurs MCP.

Licence: Open-source (licence MIT).

Langage de programmation: Le dépôt fournit des serveurs en Node.js et Python.

9. Figma

Le serveur Figma MCP est conçu pour permettre à Cursor d’accéder à vos fichiers Figma, en utilisant des outils de codage alimentés par l’IA. Son objectif est de réduire le temps nécessaire pour créer des dessins uniques, sans avoir à coller des captures d’écran.

Cas d’utilisation typiques:

- Réduire le temps nécessaire à la réalisation d’un POC: Vous utiliserez ce serveur pour réduire le temps nécessaire à la création d’un POC(Proof of Concept) d’une conception Figma en demandant un LLM et en laissant l’agent d’IA faire le travail de manière autonome.

Outils clés:

get_code: Fournit une représentation structurée React + Tailwind de votre sélection Figma.get_variable_defs: Extrait les variables et les styles utilisés dans votre sélection.

Confiance et popularité de la communauté: Le dépôt a 8,6k+ étoiles.

Licence: Open-source (MIT). Figma propose plutôt des plans gratuits et payants.

Langage de programmation: Node.js.

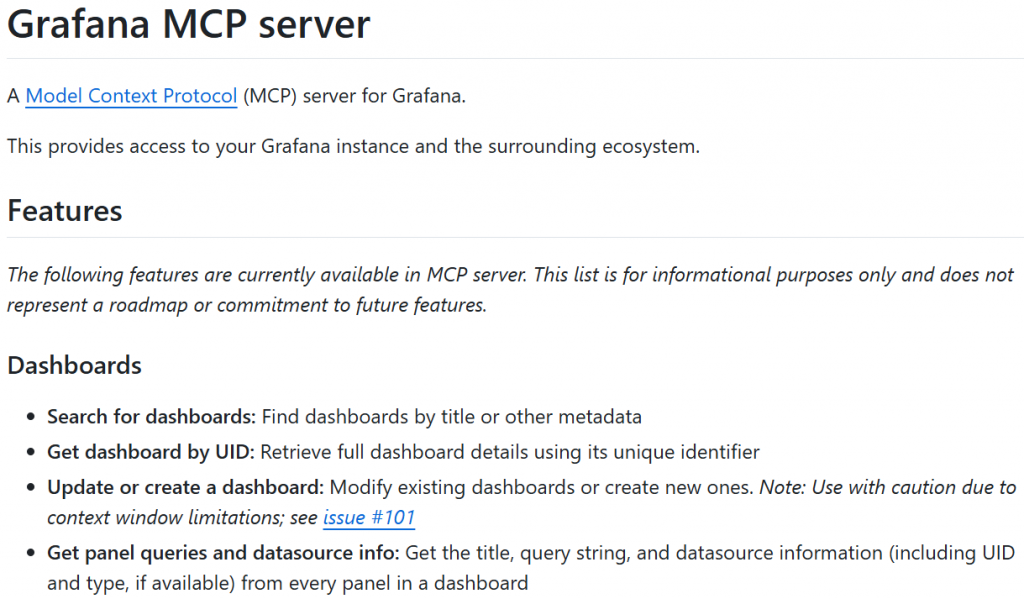

10. Grafana

Grafana est une plateforme open-source pour la visualisation, la surveillance et l’analyse des données. Elle est particulièrement appréciée pour son agnosticisme, son extensibilité et parce qu’il s’agit d’un système ouvert. Cela signifie qu’elle agit comme un hub central qui se connecte à des dizaines de sources de données différentes. Le serveur Grafana MCP vous permet de créer un agent IA qui interagit avec l’ensemble de l’écosystème Grafana.

Cas d’utilisation typiques:

- Gestion des incidents par l’IA: Vous pouvez créer des agents qui vous aideront à gérer l’ensemble du cycle de vie des incidents directement à partir de votre interface de chat. Il abaisse également la barrière d’entrée pour les systèmes d’interrogation en traduisant le langage naturel en requêtes PromQL ou LogQL spécifiques.

Outils clés:

search_dashboards: Recherche des tableaux de bord.query_prometheus: Exécute une requête sur une source de données Prometheus.list_incidents: Liste les incidents dans Grafana Incident.query_loki_logs: Interroge et récupère les journaux à l’aide de LogQL.get_analysis: Récupère une analyse spécifique d’une enquête Sift.

Automatisez votre gestion des incidents Grafana à l’aide de tous les outils disponibles.

Confiance et popularité de la communauté: plus de 1 000 étoiles, bonne documentation et contributions fréquentes.

Licence: Open-source (Apache 2.0). Pour Grafana, consultez leur page de tarification.

Langage de programmation: Go.

Meilleurs serveurs MCP : Tableau récapitulatif

Vous trouverez ci-dessous un tableau récapitulatif qui vous donnera une vue d’ensemble des serveurs MCP que vous avez découverts dans cet article :

| Entreprise | Catégorie | Langage de programmation | Lien vers le référentiel | Étoiles GitHub | Licence serveur MCP |

|---|---|---|---|---|---|

| Bright Data | Des données pour toute application d’IA | Node.js | brightdata/brightdata-mcp |

700+ | MIT |

| GitHub | Flux de travail de version | Aller | github/github-mcp-server |

16k+ | MIT |

| Supabase | Base de données | Node.js | supabase-communauté/supabase-mcp |

1.7k+ | Apache 2.0 |

| Dramaturge | Automatisation du navigateur | Node.js | microsoft/playwright-mcp |

12.8k+ | Apache 2.0 |

| Notion | Gestion des connaissances | Node.js | makenotion/notion-mcp-server |

2.3k+ | MIT |

| Atlassian | Collaboration d’équipe | Python (uniquement via Docker) | sooperset/mcp-atlassian |

2.1k+ | MIT |

| Serena | Flux de travail de codage | Node.js | oraios/serena |

2.9k+ | MIT |

| Système de fichiers | Opérations sur le système de fichiers | Node.js, Python | modelcontextprotocol/servers/tree/main/src/filesystem |

56k+ (pour l’ensemble du projet) | MIT |

| Figma | Conception de flux de travail | Node.js | GLips/Figma-Context-MCP |

8.6k+ | MIT |

| Grafana | Observabilité | Aller | grafana/mcp-grafana |

1k+ | Apache 2.0 |

Maintenant que vous connaissez les meilleurs serveurs MCP, vous pouvez apprendre à les utiliser en lisant ces guides :

- Intégrer Qwen-Agent à MCP pour créer des agents avec un accès direct aux données

- Web Scraping avec les serveurs MCP : Un guide pas à pas

- Intégration de Google ADK avec un serveur MCP pour le développement d’agents d’intelligence artificielle

- Construire des agents d’exploration du Web avec CrewAI et le protocole MCP (Model Context Protocol) de Bright Data

Conclusion

Dans cet article, vous avez appris ce qu’est un serveur MCP et pourquoi il est utile. Vous avez exploré les principaux facteurs à prendre en compte pour choisir les meilleurs serveurs MCP du marché. Enfin, vous avez vu comment ces critères s’appliquent dans une liste des 10 meilleures options disponibles.

Parmi les options proposées, le serveur MCP de Bright Data se distingue comme l’un des meilleurs. La raison en est simple : tout projet ou flux de travail d’IA dépend de données de haute qualité !

C’est précisément là que le serveur MCP de Bright Data excelle. Il donne à l’IA la possibilité de récupérer de manière éthique les données dont elle a besoin sur le Web, la source d’informations la plus vaste et la plus riche de la planète.

Désormais, lorsque vous créez des flux de travail d’IA prêts pour la production, vous avez besoin d’outils capables d’extraire, de valider et de transformer le contenu Web de manière fiable. C’est précisément ce que vous trouverez dans l’infrastructure d’IA de Bright Data.

Créez un compte Bright Data et essayez tous nos produits et services pour le développement de l’IA !