Dans ce guide, vous comprendrez :

- Pourquoi le monde passe de la GenAI à l’ère de l’IA agentique.

- Les principales limites des grands modèles linguistiques actuels.

- Comment pallier ces limites grâce à un pipeline de connaissances agentique.

- Où et pourquoi les agents IA échouent, et ce dont ils ont besoin pour réussir.

- Comment Bright Data propose une suite complète d’outils pour maîtriser les agents IA.

Plongeons-nous dans le vif du sujet !

L’ère de l’IA agentielle : de l’IA générative aux agents IA

Selon McKinsey, environ 88 % des entreprises interrogées utilisent l’IA dans au moins une fonction commerciale. Plus intéressant encore, 23 % des répondants affirment que leur organisation déploie déjà un système d’IA agentique quelque part dans l’entreprise, tandis que 39 % expérimentent activement les agents IA.

Cela signale un passage progressif des simples pipelines GenAI à des systèmes plus avancés, basés sur des agents. Les entreprises ne se contentent plus de proposer des modèles. Elles testent désormais des agents IA dans des processus et des systèmes réels.

Pourquoi ? Parce que, par rapport aux flux de travail GenAI traditionnels, les agents IA sont autonomes, peuvent se remettre d’erreurs et poursuivre des objectifs beaucoup plus complexes. C’est ce qui permet réellement de prendre des décisions basées sur l’IA et d’obtenir des informations plus approfondies et plus exploitables.

Ce changement porte ses fruits. Dans une étude PwC menée auprès de 300 cadres supérieurs, deux tiers (66 %) ont déclaré que les agents IA apportaient une valeur mesurable, principalement grâce à une augmentation de la productivité.

Sans surprise, l’IA agentique reste l’une des tendances qui connaît la croissance la plus rapide dans ce domaine. Forbes estime que le marché de l’IA agentique passera de 8,5 milliards de dollars en 2026 à 45 milliards de dollars en 2030, ce qui souligne la rapidité avec laquelle ce paradigme gagne du terrain.

Les principales limites des agents IA

L’« IA agentique » désigne l’utilisation de l’IA par le biais d’agents IA. Il s’agit de systèmes autonomes conçus pour atteindre des objectifs spécifiques en planifiant, en raisonnant et en agissant avec une intervention humaine minimale, voire en remplacement total de l’utilisateur.

Comment font-ils cela ? En suivant une feuille de route basée sur des tâches, composée d’instructions claires, d’intégrations d’outils, d’étapes optionnelles impliquant l’intervention humaine et d’une exécution par essais et erreurs. Pour en savoir plus, consultez notre guide détaillé sur la création d’agents IA.

Un système d’IA agentique peut également s’appuyer sur plusieurs agents IA sous-jacents, chacun étant spécialisé dans une tâche spécifique. Cela semble puissant, et ça l’est. Cependant, il est important de se rappeler que le cerveau et le moteur principal de tout agent IA reste un grand modèle linguistique.

Les LLM ont transformé notre façon de travailler et d’aborder les problèmes complexes, mais ils présentent certaines limites. Les deux plus importantes sont les suivantes :

- Connaissances limitées: les connaissances d’un LLM sont limitées par ses données d’entraînement, qui représentent un instantané du passé. Par conséquent, il n’est pas au courant des événements actuels ou des changements récents, à moins d’être explicitement mis à jour ou enrichi. Il peut déduire la bonne réponse, mais il peut également produire des réponses confiantes mais incorrectes ou hallucinées.

- Absence d’interaction directe avec le monde réel: les LLM ne peuvent pas interagir avec Internet, des systèmes externes ou des environnements en direct sans outils et intégrations dédiés. Leur fonction principale est de générer du contenu, tel que du texte, des images, du code ou des vidéos, en fonction de ce qu’ils savent et de ce qu’on leur demande de faire.

Comme les agents IA sont construits sur la base des LLM, ils héritent de ces restrictions, quel que soit le cadre d’IA agentique que vous choisissez. C’est pourquoi, sans une architecture et des contrôles appropriés, tous les agents IA ne se comportent pas comme prévu.

La solution : un pipeline de connaissances agentique

Comme vous l’avez peut-être déjà deviné, le moyen le plus simple et le plus efficace de surmonter les limites inhérentes à l’IA agentielle est de doter les agents IA des outils appropriés. Ces outils doivent permettre la recherche et la récupération de données en temps réel, l’interaction avec le monde réel et l’intégration avec les systèmes et services sur lesquels les agents sont censés fonctionner.

Cependant, il ne s’agit pas seulement de fournir des outils aux agents. Il est tout aussi important de structurer leur flux logique de manière à les rendre productifs, rapides et fiables. Ainsi, avant de nous plonger dans la recherche de ces outils et leur fonctionnement, voyons comment un agent IA performant fonctionne à un niveau élevé !

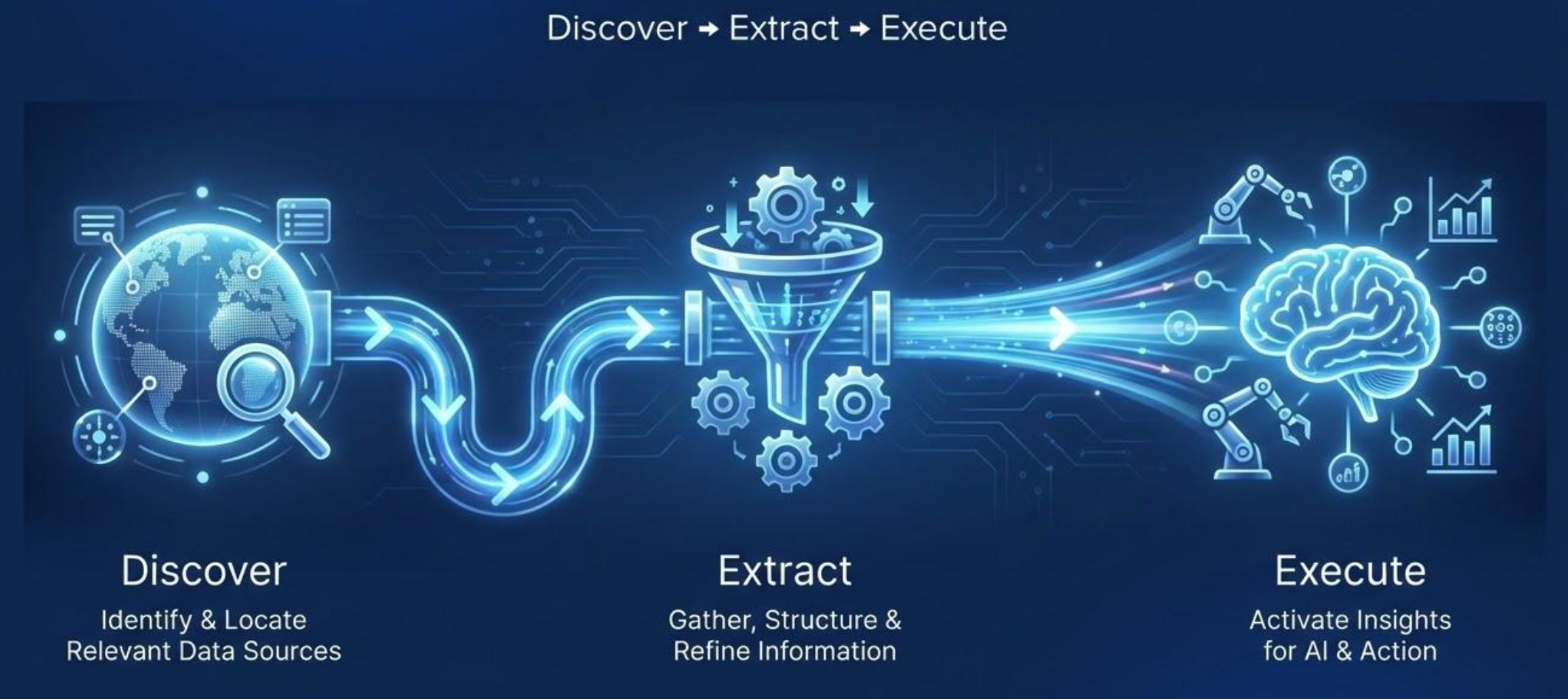

Pipeline de connaissances de l’agent : découvrir, extraire, exécuter

Réfléchissez à la manière dont nous, les humains, obtenons les meilleurs résultats. Nous sommes plus performants lorsque nous avons accès aux bonnes informations et aux bons outils, et lorsque nous savons les utiliser intelligemment. Le même principe s’applique aux agents IA.

Pour éviter les comportements peu fiables ou les mauvais résultats, les systèmes d’IA agentique doivent avoir accès à des connaissances en temps réel, vérifiables et précises. Ces connaissances peuvent ensuite être utilisées pour interagir avec le monde extérieur à l’aide d’outils appropriés.

Aussi intuitif que cela puisse paraître, un système d’IA agentique solide et pratique suit un pipeline de connaissances agentique. Celui-ci se compose de trois étapes fondamentales :

- Découvrir: identifier et localiser les sources de données pertinentes en fonction de la tâche à accomplir. L’objectif est de trouver des sources fiables et à jour qui peuvent éclairer les décisions de l’agent.

- Extraction: récupérer les données et les transformer en connaissances exploitables. Cela implique de collecter des informations, de nettoyer et de filtrer le bruit, de structurer les données non structurées et d’agréger les résultats dans un format de données cohérent que l’agent peut raisonner (par exemple, Markdown, texte brut ou JSON, dans la plupart des cas).

- Exécuter: utiliser les connaissances acquises pour prendre des décisions et mener des actions. Cela peut inclure la génération d’informations, le déclenchement de workflows ou l’interaction avec des sites web pour atteindre l’objectif visé.

Important: les deux premières étapes sont généralement appelées « phase d’acquisition de connaissances par l’agent ». Dans la plupart des applications et des cas d’utilisation, ce sont les étapes les plus importantes (et, comme nous allons le voir, celles où les choses ont tendance à se gâter).

Au cours de la phase d’acquisition de connaissances agentique, le système recherche, récupère et affine les données les plus pertinentes pour la tâche. Cela se fait généralement via un système RAG agentique dédié, qui orchestre plusieurs agents IA afin de garantir une récupération d’informations ciblée et fiable. Enfin, le système agentique prend des mesures en fonction du contexte et des connaissances recueillies précédemment.

Comment les agents IA suivent le pipeline de connaissances agentique

Gardez à l’esprit que dans la grande majorité des cas, les agents IA sont très autonomes et dotés de capacités de raisonnement. Par conséquent, ils ne suivent pas toujours le pipeline de manière strictement linéaire. Au contraire, ils passent généralement par plusieurs étapes individuelles, voire par les trois étapes.

Par exemple, si les données découvertes lors de la première étape sont jugées insuffisantes ou de mauvaise qualité, l’agent peut effectuer des recherches supplémentaires. De même, si les résultats de l’étape d’exécution ne sont pas satisfaisants, l’agent peut décider de revenir au début et d’affiner son approche. Cela reflète la manière dont les humains travaillent lorsqu’ils s’efforcent d’obtenir des résultats de haute qualité.

Un pipeline de connaissances agentique n’est donc pas seulement une ligne droite allant de la « découverte » à l’« exécution » (comme vous pourriez le voir dans un pipeline GenAI codé de manière statique). En même temps, vous n’avez pas à vous soucier de gérer manuellement ce comportement itératif, semblable à celui des humains. Le cadre ou la bibliothèque de l’agent IA s’en charge pour vous !

Cas d’utilisation pris en charge

Les systèmes d’IA agentielle alimentés par l’acquisition continue de connaissances s’ancrent profondément dans le contexte spécifique dans lequel ils doivent fonctionner. Cette conscience situationnelle leur permet de couvrir une longue liste de scénarios, notamment

| Cas d’utilisation | Description |

|---|---|

| Enrichissement agentique | Enrichissez les profils des personnes, des entreprises ou des produits à grande échelle avec une grande précision. |

| Données alternatives | Les agents ingèrent et vérifient en permanence les signaux du marché à longue traîne pour obtenir des informations allant au-delà des sources standard. |

| Analyse automatisée du marché | Analysez les tendances, les prix et les signaux de la demande pour orienter vos décisions stratégiques. |

| Suivi ESG | Agrégez les données fragmentées relatives à l’environnement, à la société et à la gouvernance afin d’offrir une vision transparente de l’impact d’une entreprise en matière de développement durable. |

| Protection de la propriété intellectuelle et de la marque | Analysez les marchés et les registres afin de détecter toute utilisation non autorisée de marques déposées ou tout produit contrefait. |

| Intelligence compétitive | Détectez les changements dans plusieurs sources, afin de découvrir les tendances et les mouvements des concurrents au-delà de ce qui est évident. |

| Recherche verticale | Explorez et normalisez régulièrement les sources spécifiques à un domaine dans un index en temps réel et à jour. |

| Surveillance réglementaire | Suivez en temps réel les mises à jour réglementaires et de conformité dans toutes les régions et tous les secteurs. |

| Renseignements sur les menaces | Identifiez les menaces de cybersécurité et les risques émergents à partir de multiples sources en ligne. |

| Recherche approfondie et vérification | Rassemblez rapidement des preuves pour valider avec précision les affirmations contenues dans des documents, des sites Web et des rapports. |

| Informations sur les réseaux sociaux | Surveillez les plateformes pour connaître les sentiments, les nouvelles tendances et l’activité des influenceurs. |

| Curation de contenu | Découvrez, filtrez et résumez les articles, documents ou actualités pertinents pour vos équipes. |

| Analyse des commentaires des clients | Agrégez et analysez les avis, les enquêtes et les mentions sur les réseaux sociaux afin d’améliorer vos produits. |

| Recherche sur les brevets et la propriété intellectuelle | Suivez en temps réel les brevets, les demandes et les activités liées à la propriété intellectuelle dans tous les secteurs. |

| Informations sur les talents et le recrutement | Surveillez la disponibilité des candidats, leurs compétences et les tendances du marché pour prendre des décisions d’embauche plus éclairées. |

Les lacunes des agents IA et ce dont ils ont besoin pour réussir

Maintenant que vous comprenez l’importance de l’IA agentique et comment créer un système efficace, il est temps d’examiner les principaux défis et exigences.

Principaux défis et obstacles

Il ne fait aucun doute que le web est la source de données la plus importante, la plus à jour et la plus utilisée au monde. Nous parlons ici d’environ 64 zettaoctets (soit 64 000 milliards de gigaoctets) d’informations !

Pour un système d’IA agentique intelligent, il n’existe pratiquement aucune alternative à la recherche et à la récupération de données directement sur Internet. Cependant, l’extraction de données du Web (appelée « Scraping web ») se heurte à de nombreux obstacles…

Les propriétaires de sites web sont bien conscients de la valeur de leurs données. C’est pourquoi, même si les informations sont accessibles au public, elles sont souvent protégées par des mesures anti-scraping telles que les interdictions d’IP, les CAPTCHA, les défis JavaScript, l’analyse des empreintes digitales et d’autres défenses anti-bot.

Cela rend la phase d’acquisition des connaissances par l’agent très exigeante. Les agents IA ont besoin d’outils qui non seulement localisent et récupèrent les données à partir des bonnes sources web, mais qui contournent également automatiquement ces protections et accèdent aux informations requises dans des formats de données compatibles avec le RAG, tels que Markdown ou JSON. Pour en savoir plus, consultez notre tutoriel sur la création d’un système RAG agentique.

La phase d’exécution peut être tout aussi complexe, en particulier si l’agent doit interagir avec des sites spécifiques ou effectuer des actions en ligne. Sans les outils appropriés, les agents IA peuvent facilement être bloqués ou empêchés d’accomplir leurs tâches.

Conditions requises pour réussir

Vous comprenez désormais que les agents IA ont besoin d’un accès au Web pour être efficaces et les défis qu’ils doivent surmonter. Mais de quoi ont-ils besoin pour vraiment réussir ? Il ne suffit pas de fournir des outils de recherche, d’accès et d’interaction sur le Web…

Pour obtenir des résultats significatifs, les outils mis à la disposition des agents IA doivent être stables, évolutifs et résilients. Après tout, sans la bonne pile technologique d’IA agentielle, vous risquez d’introduire de nouveaux problèmes au lieu de solutions.

Pour fonctionner efficacement, les systèmes d’IA agentique ont besoin d’outils de récupération et d’interaction avec les données web qui garantissent :

- Une disponibilité élevée: l’infrastructure sous-jacente doit maintenir une haute disponibilité afin d’éviter les interruptions ou les erreurs pendant la collecte et le traitement des données.

- Un taux de réussite élevé: les outils doivent contourner les mesures anti-bot sur les sites web, permettant aux agents d’utiliser les moteurs de recherche, d’extraire des données web et d’interagir avec les pages sans être bloqués.

- Une forte concurrence: de nombreuses tâches impliquent la collecte de données provenant de plusieurs sites ou l’exécution de plusieurs requêtes de recherche à la fois. Une infrastructure évolutive permet aux agents d’effectuer de nombreuses requêtes simultanément, ce qui accélère les résultats.

- Des informations vérifiables: les agents IA doivent interagir avec les moteurs de recherche populaires tels que Google, Bing, Yandex et Baidu. Cela leur permet de reproduire la manière dont nous recherchons des informations : en parcourant les résultats de recherche et en suivant les URL les plus pertinentes. Cette approche garantit la vérifiabilité des données, car vous pouvez reproduire vous-même les mêmes requêtes et remonter jusqu’aux URL des pages d’origine.

- Données récentes et à jour: les outils de Scraping web doivent extraire rapidement les informations de n’importe quelle page web, y compris les flux de données en direct.

- Sortie compatible LLM: les données doivent être fournies dans des formats structurés tels que Markdown ou JSON. L’alimentation d’un LLM en HTML brut produit des résultats moins fiables, tandis que des données propres et structurées permettent un raisonnement et des analyses plus précis.

Bien sûr, ces exigences n’ont aucun sens si le fournisseur n’offre pas une documentation claire, une assistance réactive et une intégration transparente avec les outils d’IA. Vous recherchez la meilleure infrastructure de données web compatible avec l’IA sur le marché ? C’est exactement là que Bright Data entre en jeu !

Comment Bright Data aide les agents IA à éviter les blocages et à atteindre leurs objectifs

Bright Data est la principale plateforme de données web, fournissant des outils compatibles avec l’IA pour découvrir, accéder, extraire et interagir avec les données de n’importe quel site web public.

Plus précisément, elle prend en charge les pipelines d’agents grâce à un ensemble complet de services et de solutions. Ces outils permettent aux agents IA de rechercher sur le web, de collecter des données et d’interagir avec des sites à grande échelle sans être bloqués. Ils s’intègrent également à un large éventail de frameworks IA, notamment des options bien connues telles que LangChain, LlamaIndex, CrewAI, Agno, OpenClaw et bien d’autres.

Toutes ces solutions s’appuient sur une infrastructure de niveau entreprise, infiniment évolutive, soutenue par un réseau Proxy de plus de 150 millions d’adresses IP. La plateforme offre un taux de réussite de 99,99 % et une disponibilité de 99,99 %. En outre, Bright Data fournit une assistance technique 24 heures sur 24, 7 jours sur 7, ainsi qu’une documentation complète et des articles de blog détaillés pour chaque solution.

Tout cela permet de créer de puissants agents IA et des systèmes alimentés par l’IA pour l’acquisition de connaissances en temps réel. Voyons maintenant comment Bright Data prend en charge chaque étape du pipeline de connaissances des agents !

Découvrir

Bright Data soutient l’étape de découverte des données avec :

- API SERP: fournit des résultats de recherche en temps réel sur plusieurs moteurs, notamment Google, Bing, DuckDuckGo, Yandex et bien d’autres. Permet aux agents IA de trouver des sources vérifiables et de suivre des URL contextuelles.

- API Web Archive: fournit un accès filtré à une archive web massive et continuellement mise à jour, couvrant plusieurs pétaoctets de données. Prend en charge la récupération d’URL HTML historiques, d’URL multimédias et de contenus multilingues pour la recherche et les flux de travail IA.

Extraction

Bright Data soutient la phase d’extraction des données web avec :

- API Web Unlocker: contourne automatiquement les blocages à l’aide de l’empreinte digitale basée sur l’IA, de la rotation des proxys, des nouvelles tentatives, de la Résolution de CAPTCHA et du rendu JavaScript. Fournit des données web publiques de manière fiable à grande échelle, dans un format optimisé pour les LLM et à partir de n’importe quelle page web.

- API Crawl: automatise l’exploration complète d’un site à partir d’une seule URL. Découvre les URL, les suit et extrait le contenu statique et dynamique dans des formats propres et prêts pour l’IA, tels que JSON, Markdown ou HTML.

Exécuter

Bright Data alimente l’étape d’exécution de l’agent avec :

- Navigateur d’agent: un navigateur basé sur le cloud et compatible avec l’IA qui permet à des agents autonomes de naviguer sur des sites web, de cliquer, de remplir des formulaires, de gérer des sessions et d’extraire des données, tout en gérant les CAPTCHA, les défenses anti-bot et la mise à l’échelle automatique.

- Web MCP: donne aux agents IA accès à plus de 60 outils pour l’extraction de données, la récupération de flux web et l’interaction avec les pages dans un navigateur cloud. Prend en charge des intégrations rapides et simplifiées avec une large liste de solutions IA et est proposé avec un niveau gratuit.

Conclusion

Dans cet article, vous avez découvert pourquoi les systèmes d’IA agentique prennent le dessus et comment leurs agents IA sous-jacents peuvent être prêts à la production, fiables et performants. Vous avez notamment compris l’importance de fournir l’accès aux bons outils pour soutenir un pipeline de connaissances agentique.

Mais il ne s’agit pas seulement des outils que les agents IA peuvent utiliser. Il s’agit également de l’infrastructure sous-jacente qui permet à ces outils de fonctionner de manière efficace et robuste. À cet égard, Bright Data fournit une architecture de niveau entreprise pour l’IA, offrant des solutions qui prennent en charge l’ensemble des flux de travail agentique.

Inscrivez-vous dès aujourd’hui à Bright Data et commencez à intégrer nos outils de données web prêts à l’emploi pour les agents !