Dans cet article, nous en apprendrons plus sur :

- Les défis auxquels les développeurs sont confrontés lorsque les données extraites des sites web ne sont pas fiables ou sont obsolètes

- Identifier les causes des mauvais résultats de scraping

- Des suggestions pour garantir des données plus propres et plus fiables

Plongeons dans le vif du sujet !

Quelques causes de l’inexactitude des données issues du scraping web

Avant d’apprendre comment améliorer la précision de vos données de scraping, vous devez connaître certaines des causes de ces problèmes. Dans cette section, vous découvrirez quelques-uns des problèmes que vous pouvez rencontrer lors du scraping. Certains d’entre eux sont des contenus dynamiques, des changements fréquents dans le DOM, etc.

Le contenu rendu par JavaScript crée des lacunes dans les données

Lessites web utilisant beaucoup de JavaScript char gent le contenu de manière asynchrone après la réponse HTML initiale, ce qui laisse les scrapeurs HTTP traditionnels avec des structures de page incomplètes. Lorsque vous demandez une page, vous ne recevez que le squelette HTML initial avant l’exécution de JavaScript. Les listes de produits sur les sites de commerce électronique, les commentaires des utilisateurs sur les plateformes sociales et le contenu à défilement infini se chargent généralement par des appels AJAX qui interviennent quelques millisecondes ou quelques secondes après le chargement de la page.

Ce décalage temporel amène les scrapeurs à extraire des éléments de type placeholder, des spinners de chargement ou des conteneurs vides au lieu de données réelles. Le code HTML récupéré peut contenir <div class="product-list" data-loading="true"></div> au lieu des informations sur les produits.

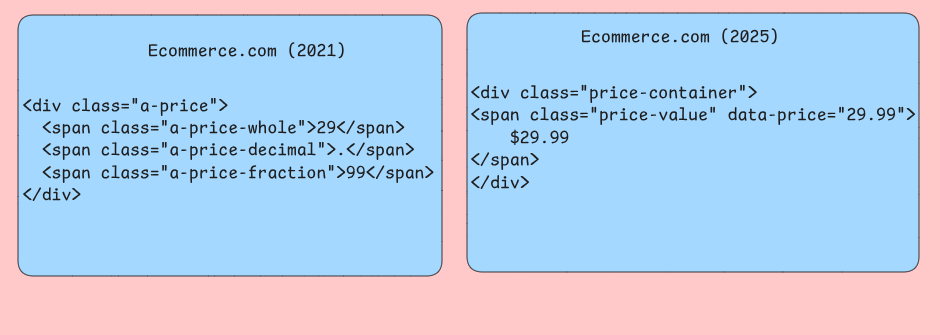

Évolution incohérente de la structure DOM

Les sites web modifient fréquemment leur structure HTML sans maintenir la compatibilité ascendante pour les outils automatisés. Ils peuvent avoir des sélecteurs CSS qui ont fonctionné de manière fiable pendant des mois et qui, tout à coup, renvoient des résultats vides lorsque les développeurs changent les noms des classes, restructurent les mises en page ou déplacent les éléments vers des conteneurs parents différents. Votre Scraper peut cibler des sélecteurs .product-price qui sont renommés en .item-cost lors de la refonte d’un site web.

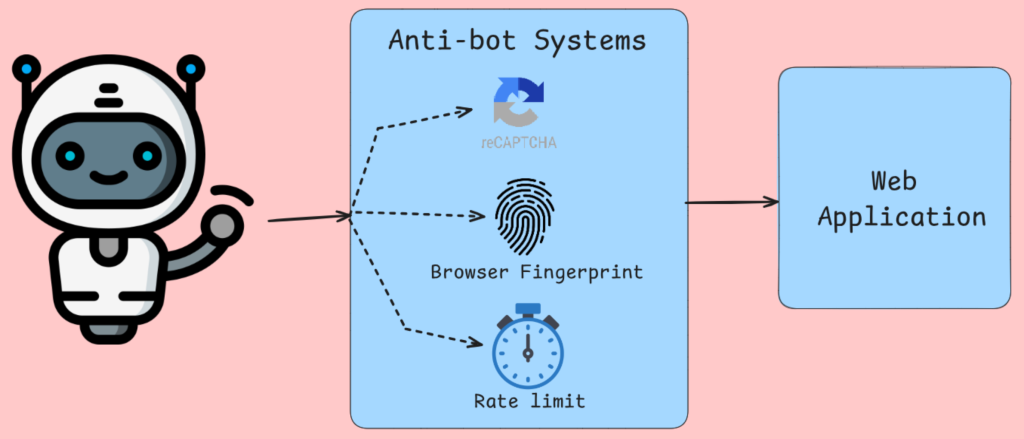

Les systèmes anti-bots altèrent la collecte des données

La détection des robots ne se limite pas au blocage des adresses IP, à l’analyse des empreintes digitales du navigateur, aux mouvements de la souris et à d’autres vérifications bien connues. Des outils comme Cloudflare et d’autres services similaires injectent des défis JavaScript qui nécessitent l’exécution du navigateur pour être menés à bien. Après la vérification du navigateur, vous recevrez un contenu alternatif ou des pages d’erreur pour les requêtes qui échouent à ces tests. Votre Scraper reçoit des pages CAPTCHA, des messages d’accès refusé ou des données délibérément trompeuses au lieu d’un contenu légitime.

Les algorithmes de limitation du débit suivent la fréquence des demandes par adresse IP, chaîne d’agent utilisateur, etc. Grâce à ces informations, le trafic est limité ou bloqué s’il ressemble à une activité humaine.

Problèmes de rendu côté serveur

Le rendu sur le serveur avec des frameworks comme Next.js, génère des sorties HTML différentes basées sur des critères différents. La même URL peut renvoyer des structures de contenu complètement différentes en fonction de facteurs que votre Scraper ne contrôle pas ou ne simule pas avec précision. Le contenu personnalisé, les informations géolocalisées et la tarification spécifique à l’utilisateur créent des scénarios dans lesquels votre scraper voit des données différentes de celles des utilisateurs prévus.

Les couches de mise en cache entre votre scraper et les serveurs d’origine introduisent des incohérences temporelles lorsque le contenu récemment mis à jour prend du temps à se propager à travers les nœuds CDN. Votre Scraper peut récupérer des prix de produits périmés, des niveaux de stocks obsolètes ou des pages d’erreur mises en cache qui ne reflètent pas l’état actuel du site web. Les serveurs Edge situés dans des régions géographiques différentes peuvent servir des versions mises en cache différentes, ce qui fait que la cohérence des données dépend du serveur qui répond à vos demandes.

Corruption des données au niveau du réseau

Les connexions réseau instables, les problèmes liés aux serveurs Proxy et les problèmes de résolution DNS entraînent une corruption subtile des données, difficile à détecter par le traitement standard des erreurs. Les téléchargements partiels de contenu créent des réponses HTML tronquées qui s’analysent correctement mais ne contiennent pas de sections de pages critiques. Votre Scraper peut recevoir les premiers 80 % d’une page de liste de produits et sembler fonctionner correctement tout en manquant systématiquement des éléments qui se chargent au bas de pages plus longues.

Les algorithmes de compression corrompent parfois les données pendant la transmission, en particulier lors de l’utilisation de Proxy rotatifs avec différents paramètres de compression.

Quel est l’impact de données inexactes sur les applications ?

Des données de scraping web inexactes affectent les systèmes d’une manière qui compromet fondamentalement la logique commerciale et l’expérience des utilisateurs. La compréhension de ces défaillances aide les développeurs à construire des pipelines de données et des couches de validation plus résistants.

Dégradation du pipeline analytique

Les problèmes de qualité des données se manifestent le plus visiblement dans les systèmes d’analyse où les agrégations amplifient les erreurs sous-jacentes. Lorsque les données de tarification du commerce électronique récupérées contiennent des erreurs d’analyse qui convertissent “29,99 $” en “2999” en raison de défaillances dans le traitement des symboles de devise, les calculs de prix moyen n’ont plus aucun sens.

Les jointures de bases de données peuvent échouer à votre insu lorsque les identifiants de produits récupérés contiennent des caractères Unicode invisibles ou des espaces blancs à la fin. Un système de suivi des produits peut présenter le même article sous forme d’entrées distinctes, ce qui gonfle les stocks et fausse les modèles de prévision de la demande. Ces défauts de normalisation se retrouveront dans tous vos processus ETL et feront en sorte que les rapports en aval doublent les recettes.

Défaillances des systèmes de prise de décision

Les systèmes décisionnels automatisés construits à partir de données récupérées peuvent faire des choix catastrophiquement erronés lorsque la qualité des données d’entrée se dégrade. Les applications de surveillance des prix qui s’appuient sur des données de concurrents récupérées sur des sites web dynamiques capturent souvent des valeurs de remplacement telles que “Loading…” ou des messages d’erreur JavaScript au lieu des prix réels. Lorsque ces chaînes non numériques contournent les couches de validation, les algorithmes de tarification peuvent prendre des valeurs nulles par défaut.

Si vous travaillez sur un moteur de recommandation Les moteurs de recommandation souffrent d’ensembles de données scrapés incomplets où certaines catégories de produits échouent systématiquement à capturer en raison de problèmes de pagination ou de barrières d’authentification. Le biais de recommandation qui en résulte en faveur des catégories scrappées avec succès crée des chambres d’écho qui réduisent la découverte de produits divers par les clients, ce qui limite en fin de compte la croissance du chiffre d’affaires et la satisfaction des clients.

Dégradation des performances des applications

Les applications qui consomment des données extraites connaissent des problèmes de performance lorsque les problèmes de qualité des données entraînent des opérations de base de données inefficaces. Les champs de texte scrappés contenant des balises HTML non codées peuvent perturber l’indexation de la recherche, entraînant des balayages complets de la table au lieu de recherches optimisées dans l’index. La fonctionnalité de recherche orientée vers l’utilisateur ne répond plus lorsque ces pénalités de performance s’accumulent sur plusieurs requêtes simultanées.

Les stratégies d’invalidation du cache échouent lorsque les données récupérées contiennent un formatage incohérent qui rend impossible la détection des doublons. Les mêmes informations sur les produits, récupérées à différents moments, peuvent apparaître comme des entrées de cache distinctes en raison d’une gestion différente des espaces blancs, ce qui augmente l’utilisation de la mémoire et réduit les taux de réussite du cache. Cette pollution du cache oblige les applications à effectuer des appels répétés et coûteux à la base de données, ce qui dégrade la réactivité globale du système.

Problèmes d’intégration des données

Les données extraites arrivent rarement de manière isolée. Elles sont généralement associées à des bases de données internes et à des API tierces pour créer des Jeux de données complets. Les incohérences de schéma deviennent courantes lorsque les structures des champs récupérés changent de manière inattendue à la suite d’une refonte du site web. Un système de catalogue de produits peut perdre des spécifications essentielles lorsque la logique de récupération ne parvient pas à s’adapter aux nouvelles mises en page HTML, laissant les applications en aval avec des informations incomplètes sur les produits, ce qui affecte les résultats de recherche et les décisions d’achat des clients.

Les incohérences dans la fraîcheur des données créent une situation où les données récupérées reflètent des périodes différentes des données internes correspondantes. Les applications financières qui combinent des données de marché récupérées avec des enregistrements de transactions internes peuvent produire des évaluations de portefeuille incorrectes lorsque les délais de récupération entraînent un décalage entre les informations sur les prix et l’horodatage des transactions. Ces incohérences temporelles rendent difficile l’établissement de pistes d’audit précises.

Différentes façons d’améliorer la précision des données

La précision des données dans le Scraping web dépend de la mise en œuvre de techniques multiples qui fonctionnent ensemble pour résoudre les différents points de données dans le pipeline d’extraction.

Traiter le contenu dynamique avec des navigateurs sans tête

Les scrapeurs traditionnels basés sur le protocole HTTP passent à côté d’une grande partie des données, car de nombreux sites web s’appuient fortement sur le JavaScript pour rendre le contenu après le chargement initial de la page. Les navigateurs sans tête comme Puppeteer ou Playwright exécutent le JavaScript comme des navigateurs ordinaires, ce qui vous permet de capturer tout le contenu généré dynamiquement.

Puppeteer permet de contrôler le rendu des pages grâce à l’intégration du protocole Chrome DevTools. Vous pouvez attendre que des requêtes réseau spécifiques se terminent, surveiller les modifications du DOM et même intercepter les appels d’API qui alimentent le contenu. Cette approche s’avère particulièrement précieuse pour les applications à page unique qui chargent des données par le biais de requêtes AJAX après le rendu initial.

Lorsque vous utilisez des navigateurs sans tête, désactivez les images, les feuilles de style CSS et les plugins inutiles afin de réduire la consommation de mémoire et d’améliorer les temps de chargement. Configurez la taille de la fenêtre de visualisation de manière appropriée, car certains sites affichent des contenus différents en fonction des dimensions de l’écran.

S’adapter rapidement aux changements de structure des sites web

Les structures des sites web changent fréquemment et freinent les scrapeurs qui s’appuient sur des sélecteurs CSS fixes ou des expressions XPath. Pour créer des scrapeurs adaptatifs, il faut mettre en œuvre des stratégies de repli et des systèmes de surveillance qui détectent les changements structurels avant qu’ils n’entraînent une perte de données.

Créez des hiérarchies de sélecteurs qui tentent plusieurs approches pour localiser le même élément de données. Commencez par le sélecteur le plus spécifique et revenez progressivement à des sélecteurs plus généraux.

classe AdaptiveSelector :

def __init__(self, selectors_list, element_name) :

self.selectors = selectors_list

self.element_name = element_name

self.successful_index = 0

def extract_data(self, soup) :

for i, selector in enumerate(self.selectors[self.successful_index :], self.successful_index) :

elements = soup.select(selector)

if elements :

self.successful_index = i

return [elem.get_text(strip=True) for elem in elements]

raise ValueError(f "Aucun sélecteur trouvé pour {self.element_name}")

# Utilisation

price_selector = AdaptiveSelector([

'div.price-current .price-value', # Plus spécifique

'.price-current', # Intermédiaire

'[class*="price"]' # Large fallback

], 'product_price')Mettre en œuvre des systèmes de détection des changements qui comparent les empreintes de la structure des pages au fil du temps.

Valider et nettoyer les données extraites

Les données brutes extraites contiennent de nombreuses incohérences qui affectent l’exactitude de vos données. Pour y remédier, vous devez mettre en place un pipeline complet de validation et de nettoyage. Celui-ci transforme les données web désordonnées en jeux de données fiables adaptés au traitement en aval.

Lavalidation des données commence par la vérification du type et du format. Les analyses doivent correspondre aux modèles de devises, les dates doivent être analysées correctement et les champs numériques doivent contenir des nombres valides.

import re

from datetime import datetime

from typing import Optional, Dict, Any

classe DataValidator :

def __init__(self) :

self.patterns = {

'prix' : re.compile(r'[$€£¥] ?[d,]+.?d*'),

'email': re.compile(r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+.[a-zA-Z]{2,}$'),

'phone': re.compile(r'^+?[ds-()]{10,}$'),

'date': re.compile(r'd{4}-d{2}-d{2}|d{2}/d{2}/d{4}')

}

def validate_record(self, record : Dict[str, Any]) -> Dict[str, Any] :

cleaned_record = {}

for field, value in record.items() :

if value is None or str(value).strip() == '' :

cleaned_record[field] = None

continuer

cleaned_value = self._clean_field(field, str(value))

if self._is_valid_field(field, cleaned_value) :

cleaned_record[field] = cleaned_value

else :

enregistrement_nettoyé[champ] = aucun

return cleaned_record

def _clean_field(self, field_name : str, value : str) -> str :

# Supprime les espaces blancs supplémentaires

cleaned = re.sub(r's+', ' ', value.strip())

# logique d'effacement

return cleaned

def _is_valid_field(self, field_name : str, value : str) -> bool :

if 'prix' in nom_de_champ.lower() :

return bool(self.patterns['price'].match(value))

elif 'email' in field_name.lower() :

return bool(self.patterns['email'].match(value))

# Ajouter d'autres validations spécifiques aux champs

return len(value) > 0Mettez en œuvre la détection des valeurs aberrantes pour identifier les points de données suspects qui pourraient indiquer des erreurs de scraping. Les méthodes statistiques telles que l’analyse de l’intervalle interquartile permettent de repérer les prix, les quantités ou d’autres valeurs numériques qui se situent en dehors des fourchettes attendues. Les algorithmes de similarité des chaînes de caractères permettent de détecter les champs de texte corrompus ou les erreurs d’extraction.

Mise en œuvre de la gestion des erreurs et des nouvelles tentatives

Les pannes de réseau, les erreurs de serveur et les exceptions d’analyse sont inévitables dans les opérations de scraping web. En dotant votre Scraper d’un système complet de gestion des erreurs, vous éviterez que des défaillances individuelles ne se transforment en pannes complètes, tandis que les mécanismes de réessai gèrent automatiquement les problèmes temporaires.

Les mécanismes de relance traitent automatiquement les problèmes temporaires. Le délai exponentiel constitue une stratégie efficace pour gérer la limitation du débit et la surcharge temporaire du serveur. Commencez par des délais courts et augmentez progressivement les temps d’attente pour les tentatives suivantes. Cette approche donne aux serveurs le temps de se rétablir tout en évitant les tentatives agressives qui pourraient déclencher des mesures anti-bots.

import asyncio

import aiohttp

from typing import Optional, Callable

classe ResilientScraper :

def __init__(self, max_attempts=3, base_delay=1.0) :

self.max_attempts = max_attempts

self.base_delay = base_delay

self.session = None

async def fetch_with_retry(self, url : str, parse_func : Callable) -> Optional[Any] :

for attempt in range(self.max_attempts) :

try :

if attempt > 0 :

delay = self.base_delay * (2 ** attempt)

await asyncio.sleep(delay)

async avec self.session.get(url) as response :

if response.status == 200 :

content = await response.text()

return parse_func(content)

elif response.status == 429 : # Taux limité

continue

elif response.status >= 500 : # Erreur de serveur

continue

else : # Erreur du client

return None

except (aiohttp.ClientError, asyncio.TimeoutError) :

continue

return NoneLes modèles de coupe-circuit empêchent les Scraper de submerger les services défaillants. Suivez les taux d’erreur pour les différents domaines et désactivez temporairement les requêtes lorsque les taux d’échec dépassent les seuils acceptables. Cette approche protège à la fois votre Scraper et le site web cible d’une charge inutile pendant les pannes.

Utiliser des Proxy rotatifs et des agents utilisateurs

Le blocage d’IP représente l’un des obstacles les plus courants dans le domaine du scraping web à grande échelle. La rotation des Proxy rotatifs et des agents utilisateurs répartit les demandes sur différentes sources apparentes, ce qui rend la détection beaucoup plus difficile tout en maintenant la vitesse de scraping.

Larotation des Proxy rotatifs nécessite une gestion minutieuse des pools de connexions et de la distribution des requêtes. Évitez d’utiliser le même Proxy pour des requêtes consécutives vers le même domaine, car ce schéma reste détectable. Au lieu de cela, mettez en œuvre des algorithmes de sélection aléatoire ou round-robin qui garantissent une distribution uniforme dans votre pool de proxies.

import random

from typing import List, Dict, Optional

classe ProxyRotator :

def __init__(self, proxies : List[str], user_agents : List[str]) :

self.proxies = proxies

self.user_agents = user_agents

self.failed_proxies = set()

def get_next_proxy_and_headers(self) -> tuple[Optional[str], Dict[str, str]] :

available_proxies = [p for p in self.proxies if p not in self.failed_proxies]

if not available_proxies :

self.failed_proxies.clear()

proxies_disponibles = self.proxies

Proxy = random.choice(available_proxies)

user_agent = random.choice(self.user_agents)

headers = {

'User-Agent' : user_agent,

'Accept' : 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language' : 'en-US,en;q=0.5',

'Connection' : 'keep-alive'

}

return proxy, headers

def mark_proxy_failed(self, proxy : str) :

self.failed_proxies.add(proxy)La rotation des agents utilisateurs doit imiter la distribution réaliste des navigateurs que l’on trouve dans les données d’analyse du web. Pondérez votre liste d’agents utilisateurs en fonction des statistiques de parts de marché réelles, en veillant à ce que les variantes de Chrome apparaissent plus fréquemment que les navigateurs moins courants. Incluez des agents utilisateurs mobiles pour les sites dont le contenu est différent pour les appareils mobiles.

Gestion des proxys pilotée par l’IA

Lors du scraping de données, les interdictions d’IP deviennent un défi qui peut interrompre complètement vos opérations. Considérons le scraping d’un site de voyage pour les prix des vols, les sites Web peuvent facilement détecter plusieurs demandes provenant de la même adresse IP à des vitesses rapides, ce qui rend simple pour eux de signaler et d’interdire votre scraper.

La solution réside dans la gestion des Proxy pilotée par l’IA plutôt que dans la rotation des Proxy de base. Cette approche utilise un Pool de proxies pour répartir les demandes sur différentes adresses IP, masquant ainsi efficacement votre identité. Des services professionnels comme Bright Data offrent un accès à plus de 150 millions d’IPs résidentielles provenant d’environ 195 pays.

La gestion intelligente des proxys offre plusieurs avantages clés. Elle garantit l’anonymat afin que les sites web ne puissent pas remonter directement à vous en cas d’activité suspecte, et met en œuvre une limitation dynamique du débit qui ajuste la fréquence des requêtes afin d’imiter le comportement humain.

Ces stratégies s’associent pour créer des scrapeurs qui conservent l’exactitude des données dans plusieurs environnements web. Les navigateurs sans tête capturent le contenu complet, les sélecteurs adaptatifs gèrent les changements structurels, les pipelines de validation nettoient les données extraites, la gestion complète des erreurs prévient les défaillances et la gestion des Proxy pilotée par l’IA optimise la livraison.

Outils et bonnes pratiques pour un scraping fiable

Le choix du bon outil de scraping dépend de la complexité de vos sites web cibles et de vos exigences en matière d’évolutivité. Cette section examine quatre catégories d’outils qui répondent aux différents défis techniques du scraping web.

Bibliothèques Python pour le contenu statique

Beautiful Soup excelle dans l’analyse des documents HTML dont le contenu se charge directement dans la réponse initiale du serveur. La bibliothèque gère gracieusement le HTML malformé et fournit des méthodes de navigation intuitives pour l’extraction de données à partir d’éléments imbriqués. Requests s’associe naturellement à Beautiful Soup pour gérer les propriétés du site dont de nombreux sites ont besoin pour accéder correctement aux données.

Scrapy fonctionne comme un cadre complet plutôt que comme une simple bibliothèque. Il gère les requêtes simultanées grâce à son planificateur intégré et les scénarios d’exploration complexes grâce à son architecture de pipeline. Vous pouvez utiliser son système de middleware pour le traitement personnalisé des requêtes, la rotation de l’agent utilisateur et les mécanismes de relance automatique.

Automatisation du navigateur pour un contenu dynamique

Selenium contrôle les navigateurs réels via les protocoles WebDriver, ce qui le rend adapté aux sites web qui dépendent fortement de l’exécution JavaScript pour le rendu du contenu. L’outil gère les interactions de l’utilisateur telles que les soumissions de formulaires, les clics sur les boutons et la pagination de défilement qui déclenchent un chargement supplémentaire du contenu. Vous devrez explicitement saisir vos conditions d’attente pour mettre en pause l’exécution jusqu’à ce que des éléments spécifiques soient disponibles ou répondent à certains critères.

Playwright offre des capacités similaires d’automatisation du navigateur avec des caractéristiques de performance améliorées et une gestion intégrée des fonctions web modernes. La fonctionnalité d’attente automatique de l’outil élimine la plupart des problèmes de synchronisation en attendant automatiquement que les éléments deviennent exploitables avant de procéder aux interactions. Les capacités d’interception du réseau de Playwright vous permettent de surveiller les appels d’API qui alimentent le contenu des pages, révélant souvent des méthodes d’accès aux données plus efficaces que l’analyse du code HTML rendu.

Solutions pour navigateurs sans tête

Puppeteer cible spécifiquement les navigateurs basés sur Chromium et offre un bon contrôle sur le comportement du navigateur grâce à l’intégration du protocole DevTools. L’outil excelle à générer des captures d’écran, des PDF et des mesures de performance en plus de l’extraction de données. Il dispose d’une fonction d’interception des requêtes que vous pouvez utiliser pour bloquer les ressources inutiles telles que les images et les feuilles de style et améliorer la vitesse de scraping pour une extraction ciblée sur le contenu.

Playwright est un outil multi-navigateur, ce qui le rend très utile pour le scraping sur différents moteurs de rendu. La fonction codegen de l’outil enregistre les interactions des utilisateurs et génère les scripts d’automatisation correspondants.

Plates-formes de gestion de proxy d’entreprise

Bright Data propose une rotation d’IPs résidentielles à travers des sites mondiaux avec des capacités de persistance de session qui maintiennent des identités cohérentes tout au long des sessions de scraping dans plusieurs pages. Le service Web Unlocker gère automatiquement les mesures anti-bots courantes, notamment la Résolution de CAPTCHA et la randomisation des empreintes digitales du navigateur. Le Navigateur de scraping combine la rotation des Proxy avec des instances de navigateur préconfigurées optimisées pour éviter la détection.

Gestion des demandes et limitation du débit

L’implémentation de stratégies de backoff évite de submerger les serveurs cibles tout en gérant les échecs temporaires de manière élégante. Par exemple, urllib3, l’un des meilleurs clients HTTP Python, fournit des mécanismes de relance avec des délais configurables entre les tentatives. La limitation personnalisée du débit à l’aide d’algorithmes de type “token bucket” permet d’adapter l’espacement des demandes à la capacité du serveur plutôt que d’appliquer des délais fixes qui peuvent être soit trop agressifs, soit insuffisants.

La gestion des sessions peut devenir importante pour les sites web nécessitant une authentification ou le maintien d’un état à travers les requêtes. Le stockage de cookies persistants et la gestion des en-têtes garantissent que les Scrapeurs conservent l’accès au contenu protégé pendant des sessions de scraping prolongées. La mise en commun des connexions réduit les frais généraux en réutilisant les connexions réseau établies pour plusieurs requêtes vers le même domaine.

Validation des données

Les bibliothèques de validation de schéma telles que l’Analyse renforcent la cohérence de la structure des données et détectent les erreurs d’analyse avant qu’elles ne se propagent dans les pipelines de traitement. La mise en œuvre de la validation de la somme de contrôle pour le contenu scrapé permet de détecter les sites web qui modifient leur structure ou le formatage de leur contenu, ce qui déclenche des alertes pour la maintenance du scraper.

Le choix entre ces outils dépend de vos besoins techniques spécifiques. Par exemple, les scrapeurs de contenu statique offrent des performances maximales pour les tâches d’extraction simples, tandis que les outils d’automatisation des navigateurs gèrent les scénarios interactifs complexes au prix d’une consommation accrue de ressources.

Conclusion

Dans cet article, nous avons découvert les défis auxquels les développeurs sont confrontés lorsqu’ils extraient des données de sites web, puis nous avons identifié les résultats d’un mauvais scraping. Enfin, nous avons découvert des outils et des stratégies qui pourraient vous aider à résoudre ces problèmes.