Cet article approfondi aborde les points suivants :

- La définition d’un outil de web scraping ;

- Les éléments à prendre en compte lors de la comparaison des meilleurs outils de web scraping ;

- Les meilleurs outils de web scraping.

C’est parti !

Qu’est-ce qu’un outil de web scraping ?

Un outil de web scraping est une bibliothèque, un logiciel ou un service qui simplifie l’extraction automatique des données d’un site. En d’autres termes, ce type d’outil facilite le web scraping.

Les entreprises, conscientes de la valeur des données qu’elles possèdent actuellement, ont tendance à les protéger, même si elles sont accessibles au public sur leurs sites. Elles ne veulent tout simplement pas les donner gratuitement. C’est pourquoi de plus en plus de sites adoptent des solutions contre le web scraping. Parmi les solutions adoptées les plus efficaces que vous devez connaître figurent les CAPTCHA, le fingerprinting et le rate limiting.

Si elles ne sont pas traitées correctement, ces solutions peuvent facilement arrêter toute opération de collecte de données. Les outils de web scraping visent justement à rendre ces solutions moins efficaces. Plus particulièrement, ils vous fournissent tout ce dont vous avez besoin pour collecter les données d’un site sans rencontrer de problème.

Il est temps de voir quels sont les meilleurs outils de web scraping, mais voyons d’abord comment sélectionner les meilleurs.

Aspect à prendre en compte lors de l’évaluation des meilleurs outils de web scraping

Voici les éléments les plus importants à prendre en compte lors de la comparaison des meilleurs outils de web scraping :

- Les avantages et les inconvénients : Analyse des principaux avantages et inconvénients des outils de web scraping.

- Les fonctionnalités : La liste des fonctionnalités proposées par l’outil.

- Le coût : Combien coûte l’abonnement premium le plus basique de l’outil de web scraping

- L’objectif principal : À quoi sert l’outil en quelques mots.

- Les plateformes : Les systèmes d’exploitation qui supportent l’outil.

- La note d’évaluation : La note donnée par les utilisateurs à l’outil sur des sites tels que Capterra.

- Les intégrations : Les technologies, outils et langages de programmation avec lesquels les outils peuvent fonctionner.

Voyons maintenant la liste des meilleures bibliothèques, technologies et outils de web scraping disponibles !

Les 11 meilleurs outils de web scraping

Découvrez quels sont les meilleurs outils pour extraire des données d’Internet et pourquoi ils figurent dans cette liste.

1. Bright Data

Bright Data est à l’avant-garde de la collecte de données sur Internet et gère un réseau proxy vaste et diversifié à l’échelle mondiale. Son réseau comporte des millions de proxys résidentiels, parfaitement adaptés à l’exécution de stratégies de rotation d’adresse IP, essentielles pour réaliser un web scraping efficace.

S’appuyant sur cette infrastructure, Bright Data propose une variété d’outils et de services de web scraping, y compris ses API Web Scraper. Cet outil basé sur le cloud propose des points de terminaison d’API personnalisables conçus pour l’extraction de données d’Internet à partir de noms de domaine populaires, répondant ainsi aux besoins complexes des projets de collecte de données.

Les API Web Scraper sont conçues pour offrir évolutivité et fiabilité, en surmontant les obstacles techniques courants rencontrés lors du web scraping, tels que le contournement des technologies anti-bot.

Par conséquent, cette solution est la solution de web scraping préférée des entreprises qui cherchent à améliorer leurs approches guidées par les données, tout en réduisant les coûts opérationnels et en améliorant l’efficacité de la collecte de données sur Internet.

- Rotation d’adresse IP via des proxys

- Résolution automatique des CAPTCHA

- Rotation des agents utilisateurs

- Capacités de rendu JavaScript

- Exportation de données dans des formats lisibles par l’homme

En d’autres termes, l’API Scraper offre, dans une seule solution, plus que la plupart des autres meilleurs outils de web scraping. Cela en fait la solution idéale pour contourner les problèmes de web scraping, réduire les coûts totaux et gagner du temps.

👍 Avantages :

👍 Avantages :

- Uptime de 99,9 %

- Échelle illimitée

- 100 % conforme et éthique

- Assistance 24/7 réalisée par des humains

👎 Inconvénients :

Inconvénients :

- Non gratuit

💰 Coût :

💰 Coût :

La tarification est basée sur le nombre d’enregistrements et le type de noms de domaine. À partir de 0,001 $.

Essai gratuit disponible.

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Gestion des demandes en bulk

- Points de terminaison d’API prêts à l’emploi

- Infrastructure évolutive

- Data discovery

- Parsing automatique

- Validation des données

- Rotation d’adresse IP automatique

- Headers personnalisés

- Système de résolution de CAPTCHA

- Rendu JavaScript

- Rotation des agents utilisateurs

- Proxys résidentiels

- Livraison de webhooks

🎯 Objectif principal : Fournir un point de terminaison configurable qui renvoie les données contenues dans une page Internet dans un format structuré. De même, il peut renvoyer le code HTML source de n’importe quelle page, même si elle est protégée par des technologies anti-bot

🎯 Objectif principal : Fournir un point de terminaison configurable qui renvoie les données contenues dans une page Internet dans un format structuré. De même, il peut renvoyer le code HTML source de n’importe quelle page, même si elle est protégée par des technologies anti-bot

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4,8/5 sur Superterra

💬 Note : 4,8/5 sur Superterra

⚙️ Intégrations :

⚙️ Intégrations :

- Tout langage de programmation qui supporte le développement Web (p. ex., JavaScript, Python, Java, Rust, Go, C#, etc.)

- N’importe quel client HTTP

- N’importe quelle bibliothèque de web scraping

2. ScrapingBee

ScrapingBee propose une API de web scraping haut de gamme qui simplifie l’extraction de données en ligne. Plus particulièrement, il gère les proxys et la configuration des navigateurs headless pour vous, afin que vous puissiez vous concentrer sur l’extraction des données. Le public ciblé est constitué de développeurs qui intègrent le point de terminaison de web scraping dans leurs scripts. Cette API est basée sur un vaste réservoir de proxys pour contourner les restrictions en matière de débit et pour réduire les risques de blocage.

👍 Avantages :

👍 Avantages :

- Vous ne payez que pour les demandes qui ont abouties avec succès

- Une documentation approfondie et de nombreux articles de blog

- Point de terminaison de web scraping facile à configurer

- De nombreuses fonctionnalités

- Efficace sur la plupart des sites

👎 Inconvénients :

Inconvénients :

- Elle n’est pas l’API de web scraping la plus rapide

- Concurrence limitée

- Nécessite des connaissances techniques

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Assistance pour les sites Internet interactifs nécessitant l’exécution de JavaScript

- Contournement automatique des technologies anti-bot, y compris la résolution des CAPTCHA

- Headers et cookies personnalisables

- Ciblage géographique

- Interceptions de requêtes XHR/AJAX

- Exportation de données aux formats HTML, JSON, XML, etc.

- Planification des appels d’API de web scraping

💰 Coût : 49 $ par mois pour un abonnement de base (essai gratuit limité disponible)

💰 Coût : 49 $ par mois pour un abonnement de base (essai gratuit limité disponible)

🎯 Objectif principal : Fournir un point de terminaison tout-en-un permettant aux développeurs d’extraire des données de n’importe quel site

🎯 Objectif principal : Fournir un point de terminaison tout-en-un permettant aux développeurs d’extraire des données de n’importe quel site

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4,9/5 sur Superterra

Note : 4,9/5 sur Superterra

⚙️ Intégrations :

⚙️ Intégrations :

- N’importe quel client HTTP

- N’importe quelle bibliothèque de web scraping

3. Octoparse

Octoparse est l’un des meilleurs outils de web scraping dans la catégorie des outils sans code. Il fournit un logiciel de web scraping capable de récupérer des données non structurées de n’importe quel site et de les transformer en ensembles de données structurés. La définition des tâches d’extraction de données est basée sur une interface pointer-cliquer simple, conçue pour les utilisateurs débutants.

👍 Avantages :

👍 Avantages :

- Outil de web scraping sans code

- Des tonnes d’intégrations

- Abonnement et essai gratuits pour les fonctionnalités avancées

- Centre de documentation et d’aide disponible dans plusieurs langues, dont l’espagnol, le chinois, le français et l’italien

- Support d’OpenAPI

- Surmonte les obstacles qui entravent le web scraping pour vous

👎 Inconvénients :

Inconvénients :

- Pas de support pour Linux

- Certaines fonctionnalités sont difficiles à comprendre

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Capacités de mise en boucle automatique

- Beaucoup de modèles pour extraire des données de sites populaires

- Assistant de web scraping basé sur l’IA

- Automatisation du cloud 24/7 pour planifier les scrapers

- Difficultés liées à la rotation d’adresse IP et à la résolution de CAPTCHA lors de réalisation de web scraping

- Rotation d’adresse IP et résolution de CAPTCHA automatiques

- Prise en charge du défilement infini, de la pagination, de la liste déroulante, du survol et de nombreuses autres simulations

💰 Coût : 75 $ par mois pour l’abonnement premium de base (abonnement et essai gratuits disponibles)

Coût : 75 $ par mois pour l’abonnement premium de base (abonnement et essai gratuits disponibles)

🎯 Objectif principal : Fournir une application de bureau permettant aux utilisateurs débutants de réaliser du web scraping, avec des intégrations avancées disponibles pour les développeurs.

🎯 Objectif principal : Fournir une application de bureau permettant aux utilisateurs débutants de réaliser du web scraping, avec des intégrations avancées disponibles pour les développeurs.

💻 Plateformes : Windows, macOS

💻 Plateformes : Windows, macOS

💬 Note : 4,5/5 sur Superterra

Note : 4,5/5 sur Superterra

⚙️ Intégrations :

Intégrations :

- Zapier

- Google Drive

- Google Sheets

- Fournisseurs de proxys personnalisés

- API Cloudmersive

- Airtable

- Dropbox

- Slack

- Hubspot

- Salesforce

4. ScraperAPI

ScraperAPI est un outil de web scraping permettant d’obtenir le code HTML de n’importe quelle page Internet, même si celle-ci est protégée par des systèmes anti-scraping. Grâce à son système avancé de détection et de contournement de technologies anti-bot, il peut se connecter à la plupart des sites sans que vos demandes ne soient bloquées. Cette API de web scraping garantit une bande passante illimitée pour les bots de web crawling.

👍 Avantages :

👍 Avantages :

- Documentation complète abordant plusieurs langages de programmation

- Plus de 10 000 clients

- Ressources, études de cas et webinaires gratuits pour se familiariser avec l’outil

- Bande passante illimitée

- Uptime de 99,9 %

- Assistance pour les professionnels

👎 Inconvénients :

Inconvénients :

- Ciblage géographique mondial disponible uniquement avec l’abonnement Pro

- Nécessite des connaissances techniques

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Capacités de rendu JavaScript

- Assistance pour les proxys premiums

- Fonctionnalité de parsing JSON automatique

- Proxy rotatif intelligent

- Headers personnalisés

- Nouveaux essais automatiques

- Assistance pour les sessions personnalisées

- Contournement des CAPTCHA et de la détection des bots

💰 Coût : 49 $ par mois pour l’abonnement premium de base (essai gratuit limité disponible)

💰 Coût : 49 $ par mois pour l’abonnement premium de base (essai gratuit limité disponible)

🎯 Objectif principal : Fournir un point de terminaison de web scraping tout-en-un permettant aux développeurs de récupérer des données depuis n’importe quelle page Internet

🎯 Objectif principal : Fournir un point de terminaison de web scraping tout-en-un permettant aux développeurs de récupérer des données depuis n’importe quelle page Internet

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note: 4,6/5 sur Superterra

Note: 4,6/5 sur Superterra

⚙️ Intégrations :

⚙️ Intégrations :

- N’importe quel client HTTP

- N’importe quelle bibliothèque de web scraping

5. Playwright

Playwright est l’une des meilleures bibliothèques de navigateurs headless. Gérée par Microsoft, elle a plus de 60 000 étoiles sur GitHub !

Playwright fournit une API complète pour les tests end to end et le web scraping. Plus précisément, Playwright offre beaucoup de fonctionnalités qui permettent de contrôler les navigateurs et de simuler des actions d’utilisateurs sur des pages Internet facilement. C’est l’outil idéal pour extraire des données de sites proposant des contenus dynamiques qui utilisent JavaScript pour le rendu ou la récupération de données. Les éléments qui font la particularité de Playwright sont sa disponibilité dans plusieurs langues et sa compatibilité avec plusieurs navigateurs et plateformes.

Découvrez cet outil en action dans notre guide sur le web scraping avec Playwright.

👍 Avantages :

👍 Avantages :

- L’outil d’automatisation de tâches de navigateur le plus complet actuellement disponible

- Développé et géré par Microsoft

- Compatible avec plusieurs navigateurs et plateformes, et disponible dans plusieurs langues

- Moderne, rapide et efficace

- Un nombre incroyable de fonctionnalités, notamment le débogage visuel, les attentes automatiques, les nouvelles tentatives, les émetteurs de rapport configurables, etc.

- API intuitive offrant uniformité en matière de langage

👎 Inconvénients :

Inconvénients :

- Pas très facile à configurer

- Maîtriser toutes les fonctionnalités prend du temps

💰 Coût : Gratuit

Coût : Gratuit

🎯 Objectif principal : Automatiser les opérations dans un navigateur en simulant les interactions des utilisateurs par la programmation

🎯 Objectif principal : Automatiser les opérations dans un navigateur en simulant les interactions des utilisateurs par la programmation

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Simulation des interactions entre les navigateurs Internet, y compris la navigation, le remplissage de formulaires et l’extraction de données

- API pour cliquer, saisir, remplir des formulaires, etc.

- Assistance pour le headed et le headless

- Assistance native pour l’exécution de tests en parallèle sur plusieurs navigateurs

- Capacités de débogage intégrées

- Émetteurs de rapports intégrés

- API d’attente automatique

💬 Note : —

💬 Note : —

⚙️ Intégrations :

⚙️ Intégrations :

- JavaScript et TypeScript

- Java

- .NET

- Python

- Navigateurs Chromium, Edge, navigateurs basés sur Chromium, Firefox, Safari, navigateurs basés sur WebKit

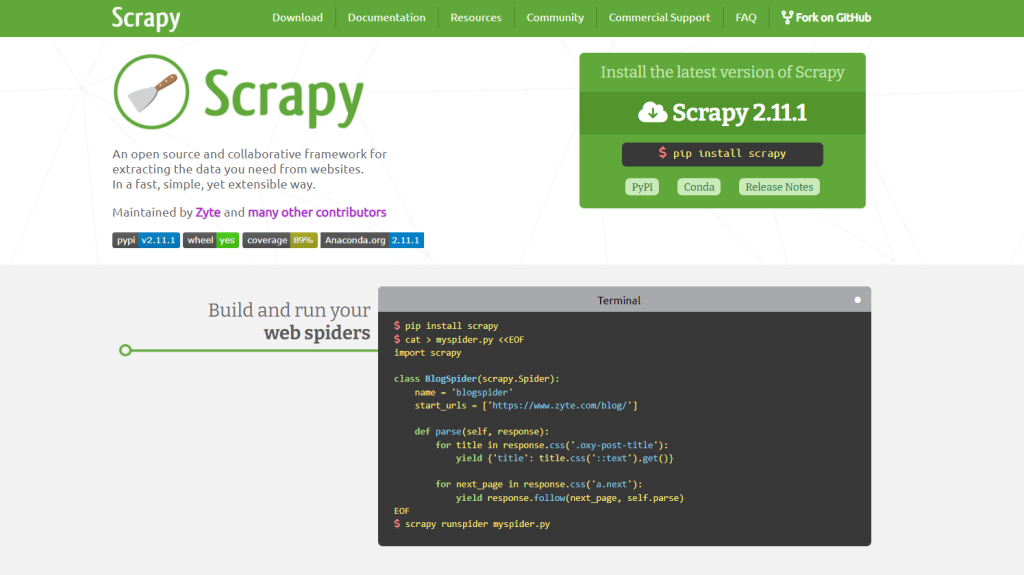

6. Scrapy

Scrapy est un logiciel open source doté d’une API complète pour le web scraping et le web crawling de sites Internet utilisant Python. Il vous permet de définir des tâches automatisées et efficaces pour explorer les sites et extraire des données de manière structurée de leurs pages.

Apprenez à l’utiliser dans notre guide sur web crawling impliquant Python avec Scrapy.

👍 Avantages :

- Logiciel de web crawling et de web scraping très rapide

- Idéal pour la récupération de données à grande échelle

- Utilisation efficace de la mémoire

- Hautement personnalisable

- Extensible via un intergiciel

- Expérience de web scraping fluide

👎 Inconvénients :

Inconvénients :

- Le scraping de sites interactifs nécessite l’intégration de Splash

- Aucune fonctionnalité intégrée d’automatisation de tâches de navigateur

- Processus d’apprentissage exigeant

🛠️ Fonctionnalités :

Fonctionnalités :

- Assistance pour les sélecteurs CSS et les expressions XPath

- Parseur HTML intégré

- Client HTTP intégré

- Logique de crawl automatique

- Parsing JSON

💰 Coût : Gratuit

Coût : Gratuit

🎯 Objectif principal : Fournir une API de web crawling et de web scraping d’excellente qualité pour le langage Python

🎯 Objectif principal : Fournir une API de web crawling et de web scraping d’excellente qualité pour le langage Python

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : —

Note : —

⚙️ Intégrations :

⚙️ Intégrations :

- Python

- Splash

7. Apify

Apify est une plateforme permettant de déployer des tâches de web scraping. Elle propose des milliers de programmes prêts à l’emploi pour le web scraping, mais elle fonctionne également avec des scripts Python et JavaScript personnalisés. La plateforme Apify permet de transformer n’importe quel site Internet en API et d’extraire des données de manière fiable à n’importe quelle échelle. Apify est l’équipe à l’origine de Crawlee, la célèbre bibliothèque Node.js pour le web scraping.

👍 Avantages :

👍 Avantages :

- Cours, académies de formation et tutoriels sur le web scraping gratuits

- Documentation complète

- Ensemble de proxys intégré

- Des tonnes d’intégrations

- Plus de 1 500 modèles de programmes de web scraping prêts à l’emploi

- De nombreux partenaires renommés nous font confiance

👎 Inconvénients :

Inconvénients :

- N’offre pas le meilleur service client

- Concurrence limitée

🛠️ Fonctionnalités :

Fonctionnalités :

- Rotation d’adresse IP intelligente

- Empreintes de navigateur similaires à celles des humains automatiques

- Cookies et headers personnalisés

- Kit d’outils de contournement de technologies anti-bot intégré

- Intégration Python et JavaScript, y compris Playwright, Puppeteer, Selenium et Scrapy

💰 Coût : 49 $ par mois pour l’abonnement premium de base (essai gratuit disponible)

💰 Coût : 49 $ par mois pour l’abonnement premium de base (essai gratuit disponible)

🎯 Objectif principal : Fournir une plateforme en ligne permettant aux développeurs de créer, déployer et gérer des tâches de web scraping

Objectif principal : Fournir une plateforme en ligne permettant aux développeurs de créer, déployer et gérer des tâches de web scraping

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4,8/5 sur Superterra

💬 Note : 4,8/5 sur Superterra

⚙️ Intégrations :

⚙️ Intégrations :

- N’importe quelle bibliothèque de web scraping

- Google Drive

- Asana

- GitHub

- Slack

- Gmail

- Zapier

8. ParseHub

ParseHub est une application de bureau de web scraping sans code qui permet de récupérer les données d’un site via une interface pointer-cliquer. Cet outil de web scraping vous permet de définir une tâche complète d’extraction de données en trois étapes :

- Consultez des pages dans un navigateur intégré

- Utilisez votre souris pour sélectionner les éléments dont vous souhaitez extraire les données et spécifiez les données à extraire

- Exportez les données extraites dans des formats lisibles par l’homme, tels que CSV ou JSON.

👍 Avantages :

- Définition d’une tâche de web scraping sans code

- Compatible avec plusieurs plateformes

- Interface utilisateur et expérience utilisateur intuitives

- Intégration fluide au cloud

👎 Inconvénients :

Inconvénients :

- Utilisation élevée du processeur

- Ne convient pas aux opérations à grande échelle

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Réalisations programmées

- Rotation d’adresse IP automatique

- Assistance pour les sites Internet interactifs

- Assistance pour les expressions conditionnelles

- Assistance pour les sélecteurs XPath, RegEx et CSS

- Extraction automatique des données des tableaux

- Extraction de données à partir d’un node Text et d’attributs HTML

- API REST et webhooks

💰 Coût : 189 $ par mois pour l’abonnement premium le plus basique (abonnement gratuit disponible)

Coût : 189 $ par mois pour l’abonnement premium le plus basique (abonnement gratuit disponible)

🎯 Objectif principal : Fournir une application de bureau sans code pour permettre aux utilisateurs débutants de réaliser du web scraping

🎯 Objectif principal : Fournir une application de bureau sans code pour permettre aux utilisateurs débutants de réaliser du web scraping

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4,5/5 sur Superterra

Note : 4,5/5 sur Superterra

⚙️ Intégrations :

⚙️ Intégrations :

- Plateforme cloud ParseHub pour stocker des données

- Clients HTTP via l’API REST de ParseHub

- Dropbox

- Service de stockage Amazon S3

9. Import.io

Import.io est une plateforme cloud qui vise à simplifier la conversion des informations semi-structurées contenues dans les pages Internet en données structurées. Ces données peuvent être utilisées à toutes fins, qu’il s’agisse d’influencer des décisions commerciales ou d’intégrer d’autres plateformes via l’API REST. Les utilisateurs peuvent définir visuellement les activités de web scraping directement sur le site d’import.io, sans avoir à installer d’application de bureau.

👍 Avantages :

- Pas besoin d’application de bureau ni d’installation d’élément supplémentaire

- Manipulation de données puissante

- API intuitive

- Efficace pour les grands sites

👎 Inconvénients :

Inconvénients :

- Documentation peu organisée

- Beaucoup plus cher que la moyenne

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Intégration de proxy premium

- Extracteur spécifique en fonction du pays

- Résolution automatique des CAPTCHA

- Notifications par e-mail

- Planification des tâches

- Gestion automatique de la pagination

💰 Coût : 399 $ par mois pour l’abonnement premium de base, avec fonctionnalités limitées (essai gratuit disponible)

Coût : 399 $ par mois pour l’abonnement premium de base, avec fonctionnalités limitées (essai gratuit disponible)

🎯 Objectif principal : Fournir une plateforme basée sur le cloud pour définir les tâches de collecte de données via une interface pointer-cliquer

🎯 Objectif principal : Fournir une plateforme basée sur le cloud pour définir les tâches de collecte de données via une interface pointer-cliquer

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 3,6/5 sur Superterra

💬 Note : 3,6/5 sur Superterra

⚙️ Intégrations :

Intégrations :

- La plupart des bibliothèques de web scraping

- Capacités d’élaboration de données

- Exportation de données programmatique via API

- Exportation de données dans plusieurs formats

10. WebScraper.io

WebScraper.io est un simple outil d’extraction de données pointer-cliquer disponible sous forme d’extension Chrome. Il permet aux utilisateurs d’extraire les données manuellement ou automatiquement directement dans le navigateur. Ces tâches d’extraction de données peuvent également être effectuées dans le cloud. Le produit est assez limité et n’offre pas toutes les fonctionnalités offertes par les autres meilleurs outils de web scraping. Cependant, il convient parfaitement pour des besoins de base et l’extraction rapide de données.

👍 Avantages :

👍 Avantages :

- Sélection d’éléments HTML visuels

- Interface facile à utiliser

- Idéal pour les besoins de base

👎 Inconvénients :

Inconvénients :

- Concurrence très limitée

- Assistance de base par e-mail

- Ne fonctionne que sur Chrome

- Conservation limitée des données dans le cloud

- Limité en cas de besoins avancés

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Exportation aux formats CSV, XLSX, JSON

- Planificateur de tâches de web scraping

- Intégration de proxy

- Fonctionnalités de parsing par pointer-cliquer dans le navigateur

- Exécution de tâches de web scraping locales et basées sur le cloud

💰 Coût : 50 $ par mois pour l’abonnement premium de base (abonnement et essai gratuits disponibles)

💰 Coût : 50 $ par mois pour l’abonnement premium de base (abonnement et essai gratuits disponibles)

🎯 Objectif principal : Fournir une extension Chrome pour définir les tâches de web scraping et les exécuter dans le cloud

🎯 Objectif principal : Fournir une extension Chrome pour définir les tâches de web scraping et les exécuter dans le cloud

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4,1/5 sur le Chrome Web Store

💬 Note : 4,1/5 sur le Chrome Web Store

⚙️ Intégrations :

Intégrations :

- Chrome

- Dropbox

- Google Sheets

- Google Drive

- Amazon S3

11. Data Miner

DataMiner fournit une extension de web scraping pour Google Chrome appelée Data Scraper. Cela vous permet de récupérer les données de pages Internet directement dans le navigateur et de les exporter au format CSV.

👍 Avantages :

👍 Avantages :

- Sessions d’assistance en direct gratuites

- Interface simple

👎 Inconvénients :

👎 Inconvénients :

- Assistance par e-mail limitée

- Disponible uniquement avec Chrome

- Limité en cas de tâche avancée de récupération de données

- La formation avancée est payante

🛠️ Fonctionnalités :

🛠️ Fonctionnalités :

- Automatisation du web crawling

- Assistance pour les scripts Javascript personnalisés

- Fonctionne pour tous les noms de domaine

- Téléchargement d’images

- Assistance pour les actions click et de défilement de page

💰 Coût : 19,99 $ par mois pour l’abonnement premium de base (abonnement gratuit disponible)

💰 Coût : 19,99 $ par mois pour l’abonnement premium de base (abonnement gratuit disponible)

🎯 Objectif principal : Fournir une extension Chrome pour extraire localement les données des pages Internet

🎯 Objectif principal : Fournir une extension Chrome pour extraire localement les données des pages Internet

💻 Plateformes : Windows, macOS, Linux

Plateformes : Windows, macOS, Linux

💬 Note : 4/5 sur le Chrome Web Store

💬 Note : 4/5 sur le Chrome Web Store

⚙️ Intégrations :

⚙️ Intégrations :

- Google Sheets

Les meilleurs outils de web scraping : Tableau récapitulatif

Si vous recherchez des informations rapides sur les meilleurs outils de web scraping, consultez le tableau suivant :

Conclusion

Dans ce guide, vous avez passé en revue certains des meilleurs outils de web scraping pour collecter des données de sites Internet. Les configurations les plus efficaces reposent généralement sur plusieurs des outils mentionnés dans cet article. Par exemple, un outil d’automatisation des tâches de navigateur tel que Playwright peut être intégré à un navigateur anti-détection. Celui-ci peut, à son tour, être intégré à des proxys. C’est assez complexe, n’est-ce pas ?

Optez pour la solution la plus simple et essayez l’API Scraper. En tant qu’API de web scraping tout-en-un, de nouvelle génération et complète en matière de fonctionnalités, elle fournit tout ce dont vous avez besoin pour extraire des données en ligne tout en évitant les technologies anti-bot. Le web scraping n’a jamais été aussi simple !

Inscrivez-vous maintenant et discutez de nos solutions de web scraping avec l’un de nos experts en extraction de données.