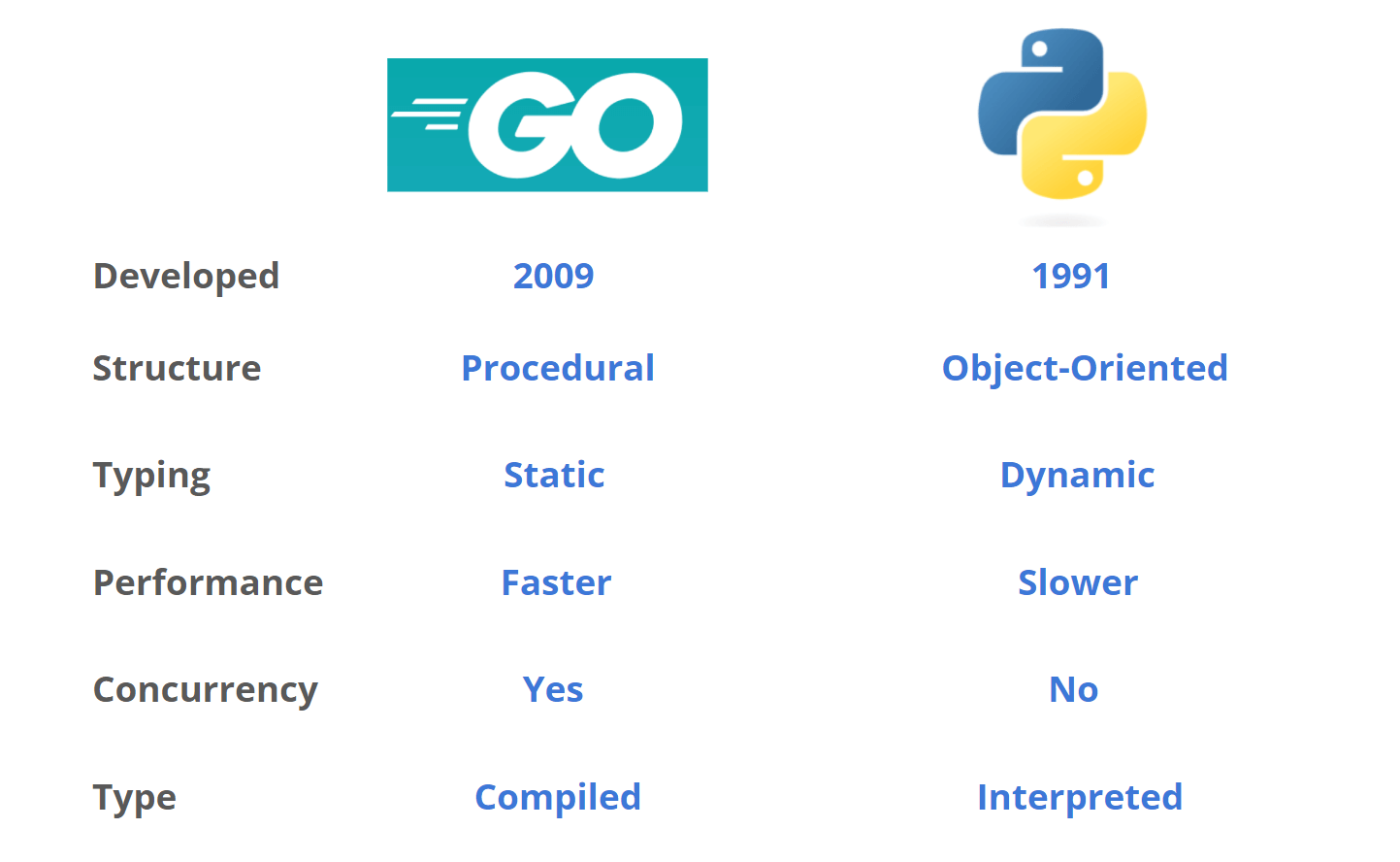

Les langages de programmation Go et Python sont tous deux des langages de Scraping web populaires grâce à leurs nombreux avantages uniques. Par exemple, l’efficacité des performances de Go, sa forte prise en charge de la concurrence et sa bibliothèque standard robuste le rendent idéal pour les tâches de Scraping web qui nécessitent une vitesse élevée et la gestion simultanée de plusieurs tâches.

En revanche, la facilité d’utilisation de Python, son écosystème étendu de bibliothèques et le soutien d’une large communauté en font un langage idéal pour le prototypage rapide et pour les débutants en Scraping web.

Que vous privilégiez les performances et l’évolutivité ou la facilité d’utilisation et le soutien de la communauté, ces deux langages offrent des outils fiables et efficaces pour les tâches de Scraping web.

Dans cet article, vous comparerez Go et Python pour le Scraping web. Vous vous intéresserez plus particulièrement à leurs performances, à leur capacité à gérer des sites web et des scénarios complexes, ainsi qu’aux bibliothèques disponibles dans chaque langage.

Qu’est-ce que Go ?

Go est un langage statiquement typé et compilé, qui offre les avantages des langages compilés en termes de performances. Il dispose également d’une inférence de types et d’une syntaxe simplifiée, qui vise à offrir une expérience de programmation plus proche de celle des langages dynamiquement typés.

Go est idéal pour le Scraping web lorsque vous avez besoin de performances et d’évolutivité élevées, vous garantissant d’obtenir vos données rapidement. La bibliothèque standard robuste de Go facilite le développement web, la manipulation des données et la mise en réseau, des composants clés des opérations de Scraping web.

Go bénéficie d’une communauté solide et du soutien de Google. Cela garantit sa continuité et son amélioration. Si vous êtes intéressé par le Scraping web avec Go, lisez ce tutoriel sur le Scraping web avec Go.

Qu’est-ce que Python ?

Python est un langage de programmation interprété, de haut niveau et à usage général. Il excelle dans le Scraping web grâce à sa bibliothèque standard étendue et à son typage dynamique. De plus, son riche écosystème de bibliothèques tierces permet une extraction et une manipulation efficaces des données.

Si la nature interprétée de Python peut compromettre ses performances, son prototypage rapide en fait souvent un choix privilégié pour les tâches de Scraping web. Si vous souhaitez en savoir plus, consultez le tutoriel Web Scraping with Python.

L’une des plus grandes forces de Python est sa communauté vaste et active, qui contribue à un écosystème de bibliothèques et de frameworks en constante expansion. Cela réduit la quantité de code que les développeurs doivent écrire à partir de zéro.

Go vs Python pour les tâches de Scraping web

Dans la comparaison suivante, Go et Python seront évalués sur la base de trois critères : les performances, la capacité à gérer des sites web/scénarios complexes et les bibliothèques disponibles.

En matière de performances, vous examinerez la vitesse et l’efficacité de chaque langage dans l’exécution de tâches de Scraping web, en tenant compte de facteurs tels que le temps de compilation et la prise en charge de la concurrence.

L’évaluation de leur capacité à gérer des sites web et des scénarios complexes montre dans quelle mesure chaque langage est capable de naviguer dans des structures de sites web complexes, de gérer les cookies et de traiter les requêtes AJAX ou le contenu chargé dynamiquement.

Enfin, l’examen de la disponibilité et de la robustesse des bibliothèques de chaque langage se concentre sur la manière dont ces outils pré-construits peuvent faciliter le processus de Scraping web, le rendant plus simple, plus efficace et plus riche en fonctionnalités.

Aller

Performances

En termes de performances, Go est particulièrement utile pour les tâches de Scraping web qui nécessitent une vitesse et une efficacité élevées. Il traduit le code source en code machine à l’avance, ce qui se traduit généralement par une exécution plus rapide. En revanche, dans un langage interprété comme Python, le code source est traduit à la volée pendant l’exécution, ce qui se traduit souvent par des performances plus lentes.

De plus, la nature compilée de Go le rend très efficace en termes d’utilisation du processeur et de la mémoire. Cette fonctionnalité permet à Go de gérer facilement des tâches de Scraping web à grande échelle. Un autre avantage de Go est sa prise en charge intégrée de la concurrence grâce aux goroutines. Cela le rend efficace pour les tâches qui impliquent d’effectuer plusieurs requêtes réseau simultanément, une exigence courante dans le Scraping web.

Le modèle de concurrence de Go s’inspire des processus séquentiels communicants (CSP), permettant la gestion de plusieurs tâches sans la complexité des modèles de threading traditionnels. Cela est particulièrement utile lorsque vous scrapez des sites web qui ont des fonctionnalités de limitation de débit ou lorsque vous devez scraper rapidement des données provenant de plusieurs pages.

La bibliothèque standard de Go propose également des packages pour une programmation réseau et une manipulation des données efficaces. Par exemple, le package HTTP est hautement personnalisable et optimisé pour la vitesse, ce qui facilite la création de Scrapers web rapides et efficaces.

Capacité à gérer des sites web/scénarios complexes

Les avantages de Go dans le domaine du scraping web ne se limitent pas à ses performances et à ses fonctionnalités de concurrence. La bibliothèque standard de Go comprend également des paquets complets pour traiter les requêtes HTTP, effectuer l’analyse du HTML et du XML, et gérer les cookies et les sessions.

De plus, le package encoding/JSON simplifie le processus d’encodage et de décodage des données JSON, une exigence courante lors de l’interaction avec les services web modernes. Cela facilite la navigation dans les structures complexes des sites web, la gestion des interactions avec état, et même le traitement des requêtes AJAX ou du contenu chargé dynamiquement. Par exemple, le packagenet/http fournit un client HTTP personnalisable qui peut être utilisé pour gérer les cookies, définir des en-têtes et traiter les redirections. Cela donne à l’utilisateur un haut degré de contrôle sur les interactions web.

Lorsqu’il s’agit de gérer des scénarios complexes, l’une des caractéristiques remarquables de Go est sa prise en charge intégrée de la concurrence grâce aux goroutines. Cela est particulièrement utile lorsqu’il s’agit de sites web qui utilisent la limitation de débit ou qui nécessitent des interactions asynchrones. L’utilisateur peut facilement générer plusieurs goroutines pour effectuer des tâches telles que la récupération simultanée de plusieurs pages ou l’attente du chargement de certains éléments. Cela rend Go efficace pour les tâches de scraping qui impliquent des données en temps réel, plusieurs sources de données ou des séquences de navigation complexes.

De plus, les mécanismes puissants de typage et de gestion des erreurs de Go peuvent être utiles dans le cadre de scénarios de scraping complexes, comme le scraping de sites web avec du contenu chargé via AJAX, qui nécessite la gestion du chargement asynchrone des données. Le système de types statiques du langage permet de détecter les erreurs au moment de la compilation, ce qui réduit le risque d’erreurs d’exécution lors de la navigation sur des sites web complexes.

Bibliothèques disponibles

L’écosystème de Go n’est pas aussi étendu que celui de Python en matière de Scraping web, mais il se développe régulièrement.

Pour l’analyse HTML, les bibliothèques telles que goquery et colly sont des choix populaires. goquery s’inspire de jQuery et vous permet de parcourir et de manipuler facilement des documents HTML. Quant à la bibliothèque colly, il s’agit d’un outil puissant spécialement conçu pour le Scraping web et le crawling. Elle offre une API claire et une variété de fonctionnalités, notamment la limitation du débit, la mise en cache et la gestion automatique des réessais.

Une autre bibliothèque notable est chromedp. Elle est utilisée pour piloter les navigateurs à l’aide du protocole Chrome DevTools et est particulièrement utile pour le scraping de sites web qui dépendent fortement de JavaScript pour charger ou afficher du contenu.

Au-delà des bibliothèques couramment utilisées telles que net/http, colly, goquery et chromedp, il existe également jaeles, qui est orientée vers les tests de sécurité, mais qui peut être adaptée à des scénarios complexes de Scraping web nécessitant des sondages ou des interactions avancés.

Python

Performances

Si Go est connu pour sa vitesse d’exécution impressionnante, Python possède ses propres avantages en termes de performances, en particulier lorsqu’il s’agit de tâches liées à l’E/S plutôt qu’au CPU. Par exemple, dans les scénarios de Scraping web, vous passez souvent plus de temps à attendre les réponses du réseau qu’à effectuer des opérations gourmandes en CPU. Dans ce scénario, la vitesse d’exécution brute du langage de programmation devient moins importante. Le Global Interpreter Lock (GIL) de Python peut nuire aux performances des tâches liées au CPU, mais il ne pose généralement pas de problème significatif pour les activités liées aux E/S telles que le Scraping web.

Python offre également plusieurs moyens d’améliorer les performances, notamment le multithreading et la programmation asynchrone. Ses bibliothèques permettent des opérations d’E/S asynchrones et permettent à l’utilisateur de traiter simultanément plusieurs requêtes réseau. Cela est particulièrement utile pour les tâches de Scraping web qui nécessitent de récupérer simultanément des données provenant de plusieurs pages ou sources.

Capacité à gérer des sites web/scénarios complexes

Grâce à son vaste écosystème de bibliothèques et de frameworks spécialisés, Python peut gérer des scénarios de scraping web complexes. Ses bibliothèques facilitent l’analyse des documents HTML et XML, la navigation dans le DOM et l’extraction des données requises.

De plus, ces bibliothèques intègrent des fonctionnalités pour gérer les cookies, traiter les sessions et traiter les requêtes AJAX, offrant ainsi une expérience simplifiée. La nature dynamique et la facilité d’utilisation de Python facilitent également l’adaptation des scripts de Scraping web pour gérer des scénarios complexes.

Par exemple, vous pouvez facilement intégrer des scripts Python à des pilotes web tels que Selenium pour interagir avec des sites web d’une manière qui imite le comportement humain, comme faire défiler des pages, remplir des formulaires ou même réaliser la Résolution de CAPTCHA. Cela est particulièrement utile lorsqu’il s’agit de sites web qui utilisent des techniques sophistiquées pour dissuader l’accès automatisé.

Bibliothèques disponibles

Python dispose d’un riche écosystème de bibliothèques et de frameworks spécialement conçus pour le Scraping web. L’une des bibliothèques les plus connues est Beautiful Soup, qui fournit des idiomes Python pour itérer, rechercher et modifier des arbres d’analyse HTML ou XML. Elle est souvent utilisée en conjonction avec la bibliothèque Requests, une bibliothèque HTTP simple mais puissante pour envoyer des requêtes HTTP et traiter les réponses.

Scrapy est un autre framework complet de Scraping web qui fournit tous les outils nécessaires pour extraire des données de sites web et les traiter. Il offre des fonctionnalités telles que la gestion des cookies, l’usurpation d’identité de l’agent utilisateur et la gestion des redirections, ce qui en fait un choix robuste pour les tâches de scraping plus complexes. Scrapy permet également d’effectuer des requêtes en parallèle, ce qui accélère considérablement le processus d’extraction des données.

Pour ceux qui recherchent une alternative légère à Selenium, MechanicalSoup automatise la navigation sur les sites web et le remplissage de formulaires sans nécessiter de navigateur sans interface graphique. Ce package est particulièrement utile pour les tâches de Scraping web qui n’impliquent pas l’exécution de JavaScript côté client, ce qui en fait une option plus rapide et moins gourmande en ressources.

Pyppeteer est une autre bibliothèque permettant de contrôler les navigateurs sans interface graphique, qui offre un port Python de la célèbre bibliothèque JavaScript Puppeteer.

En plus de celles-ci, Python dispose de bibliothèques spécialisées pour l’analyse et la manipulation de données, comme lxml pour l’analyse XML et HTML, et pandas pour la manipulation et l’analyse de données.

Conclusion

Go et Python offrent tous deux des avantages distinctifs pour le Scraping web. Go est un bon choix pour les tâches qui nécessitent des performances élevées, une grande efficacité et la capacité de gérer plusieurs tâches simultanément. Sa nature compilée et sa bibliothèque standard robuste le rendent bien adapté aux tâches de Scraping web à grande échelle et à haute vitesse.

En comparaison, Python est facile à utiliser grâce à sa large gamme de bibliothèques et de frameworks spécialisés. Python est particulièrement bien adapté au prototypage rapide et aux scénarios de Scraping web complexes. Que vous soyez débutant ou développeur expérimenté, ces deux langages offrent des outils fiables et efficaces pour le Scraping web.

Quel que soit le langage que vous choisissez pour vos besoins en matière de Scraping web, Bright Data propose une variété de solutions de déblocage et de Proxys qui peuvent vous aider. Ces solutions vous aident à contourner les obstacles courants tels que les CAPTCHA, les interdictions d’IP et les limitations de débit, garantissant ainsi le bon déroulement et l’efficacité de vos tâches de Scraping web. Grâce aux offres robustes de Bright Data, vous pouvez vous concentrer sur l’extraction des données dont vous avez besoin, quel que soit le langage que vous utilisez.

Discutez avec l’un de nos experts en données de nos solutions de scraping.